Algoritmo do Facebook radicalizou debate nos EUA; por que isso é perigoso?

Novas denúncias com base em documentos internos vazados do Facebook destacam que os algoritmos de recomendações de conteúdos usados na rede social contribuem para a disseminação de notícias falsas e estimulam a polarização. Um exemplo envolve a teoria da conspiração QAnon, que defende sem provas a ideia de que Donald Trump luta contra pedófilos e adoradores de Satanás do mundo empresarial e da imprensa.

Um teste feito por uma pesquisadora do Facebook em 2019 mostrou, segundo reportagem do New York Times, que um perfil criado para simular uma mulher, mãe, conservadora do Estado da Carolina do Norte com interesses em assuntos como o presidente Donald Trump passou a receber poucos dias depois recomendações de conteúdos relacionado ao QAnon, como sugestões de páginas para curtir ou grupos para entrar.

Especialistas ouvidos por Tilt afirmam que denúncias como essa reforçam ainda mais a "caixa preta" que envolve os algoritmos e o poder perigoso deles ao recomendarem páginas, grupos e postagens no feed de notícias dos usuários da rede social, afetando sobre o que é visto ou ocultado.

"Há indícios de que esses algoritmos tenham efeitos negativos, sim, principalmente no que diz respeito a circulação de desinformação e discursos de ódio, e que há uma possível radicalização, tanto pela ação das pessoas quanto dos mecanismos de recomendação", diz Raquel Recuero, pesquisadora da UFPel (Universidade Federal de Pelotas-RS) e coordenadora do MIDIARS (Laboratório de Pesquisa em Mídia, Discurso e Análise de Redes Sociais).

O pesquisador João Archegas, do ITS Rio (Instituo de Tecnologia e Sociedade do Rio de Janeiro), acrescenta que o algoritmo acaba refletindo em comportamentos polarizados, pois "trabalha para manter o engajamento na plataforma na interação com esses conteúdos".

"O que sabemos, de fato, é que em algum momento, por mostrar conteúdos alinhados à concepção de mundo desse internauta, o algoritmo amplifica a polarização, gerando ali mais engajamento", explica.

Desinformação: QAnon e eleição com Trump

De acordo com o jornal norte-americano, o Facebook foi alertado pelo menos outras três vezes por seus funcionários sobre a rede de desinformação que circulava em sua plataforma em relação aos grupos envolvidos com a teoria da conspiração QAnon e sobre as eleições dos EUA de 2020 (quando Donald Trump foi derrotado por Joe Biden).

A primeira aconteceu um ano e quatro meses antes da eleição presidencial norte-americana do ano passado. A outra, em 5 de novembro. Quatro dias depois, uma cientista de dados ratificou que 10% de todas as visualizações de conteúdo político dos Estados Unidos eram relacionadas a falsas informações sobre fraude na votação.

Para alguns funcionários do Facebook, a empresa falhou ou teve dificuldades em resolver o problema, destaca a reportagem. Eles acreditam que a companhia fundada por Mark Zuckerberg poderia ter feito mais para solucionar o caso.

O resultado dessa mobilização, em grande parte organizada na internet, foi a invasão ao Capitólio (Congresso dos EUA) e atos de violência incitados por Donald Trump nas redes sociais e no YouTube — o ex-presidente foi bloqueado em várias plataformas.

O Facebook culpou publicamente Donald Trump pela proliferação de notícias falsas que inflou o ataque ao Congresso. Contudo, os documentos publicados nos últimos dias demonstram que a empresa sabia desses movimentos extremistas mesmo antes do ato de vandalismo.

A reportagem não mostra como o Facebook agiu, mas sugere que a empresa tentou conter a disseminação de notícias falsas, mas ao mesmo tempo acabou se preocupando com a perda de engajamentos, o que afetaria sua reputação.

Em sua defesa sobre as recentes acusações, o Facebook publicou dois textos escritos por seus executivos. Um deles, assinado por Miranda Sissons, diretora de políticas de direitos humanos da plataforma, e por Nicole Isaac, diretora internacional de resposta estratégica, diz que:

- a rede "age rapidamente para remover conteúdo que viola nossas políticas" em países que estão sob "risco de conflito ou violência";

- Desde 2018, equipes com experiência em questões como direitos humanos, discurso de ódio, desinformação e polarização trabalham para lidar com situações assim. "Quando respondemos a uma crise, implantamos suporte específico de país conforme necessário";

- "A complexidade desses temas (...) significa que nunca haverá uma solução única que funcione para todos. Nosso trabalho nunca estará concluído e exige vigilância e investimentos constantes".

Especificamente sobre as eleições de 2020 nos EUA, um outro artigo, assinado por Guy Rosen, vice-presidente de integridade do Facebook, destaca que a rede social trabalhou para proteger o pleito eleitoral. Algumas medidas tomadas foram:

- Ajudar a registrar "mais de 4,5 milhões de eleitores";

- Montar um Centro de Operações para Eleições, com especialistas de diversas equipes da plataforma;

- Buscar operações encobertas de influência que tentavam interferir no Facebook, chegando até a derrubar redes de "comportamento inautêntico" vindas da Rússia, do Irã, da China e dos próprios EUA.

O poder dos algoritmos

Apesar de o Facebook ter dado pistas, no início de 2021, sobre o que faz um conteúdo aparecer para um usuário, o processo ainda é considerado um mistério, principalmente em relação à maneira como esses algoritmos se alimentam de informações.

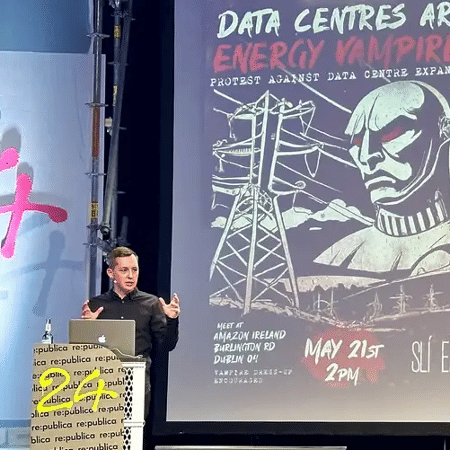

Os especialistas ouvidos por Tilt dizem que é difícil aferir com exatidão como os algoritmos influenciam o comportamento individual ou coletivo. Contudo, já existem indícios de que plataformas de interação social (e não só o Facebook) são capazes de mediar debates públicos, incitar protestos, revoluções e ajudar até eleger presidentes.

Por esse poder todo, os entrevistados defendem que o Facebook e outros grupos de responsáveis por redes sociais devem ser mais claros sobre seu funcionamento. Uma regulação maior dessas empresas, com melhor supervisão de suas práticas, também é defendida por eles.

"A ferramenta deveria ser mais transparente quanto a esses algoritmos e como eles funcionam porque isso interfere no modo como as pessoas percebem os conteúdos. É preciso algum tipo de regulação. E isso não é verdade apenas para o Facebook, mas também para o YouTube [do Google], por exemplo", analisa Recuero.

"Há um risco e precisamos de mais transparência, principalmente na maneira como estrutura seu algoritmo para saber o real dano deles. As entidades regulatórias devem exigir mais sobre isso", reforça Archegas.

Até hoje não existe uma regulamentação específica para como devem atuar as redes sociais nem no Brasil nem no mundo. Em seu depoimento ao Senado dos EUA, Frances Haugen, delatora do Facebook, também destacou que a criação de uma agência reguladora dedicada a supervisionar empresas como a rede social pode ajudar a tornar as plataformas menos prejudiciais.

Como o Facebook decide o que você vê no feed

Alguns fatores, segundo o Facebook, afetam diretamente o que você vê ao rolar a linha do tempo na rede social. A empresa diz que as publicações, sugestões de amizade, páginas e grupos são influenciados pelos seguintes mecanismos de comportamento.

- Engajamento relacionado: se outras pessoas que interagiram com o post também interagiram anteriormente com o mesmo grupo, página ou postagem que você;

- Tópicos relacionados: se você recentemente se envolveu em um tópico do Facebook, o algoritmo traz postagens de temas parecidos com o desse tópico;

- Localização: postagens sugeridas com base em onde você está (que usa os dados do GPS do seu celular, por exemplo) e com o que as pessoas próximas a você estão interagindo no Facebook.

*Com informações de Thiago Varella e Aurélio Araújo

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.