Como a 'guerra cultural' fez o Google proibir IA de criar imagem de pessoas

Os Estados Unidos vivem uma "guerra cultural" toda própria, mas que também é um produto de exportação. Ela está centrada na ascensão do pensamento woke (que inglês significa "acordei") e na reação conservadora a esse movimento. A disputa mistura questões como o combate ao racismo, inclusão e visões sobre meritocracia. Após tomar o debate político, até gerou uma importante decisão da Suprema Corte dos EUA.

O tema está no centro da última polêmica envolvendo a criação de imagens por inteligência artificial. O Gemini, aplicação da Google que gera imagens através de comandos (prompts), estava criando personagens históricos com diversidade étnica e de gênero. Então apareceram oficiais nazistas e vikings negros, além do papa como uma mulher indiana.

Tudo certo se os resultados fossem uma expressão artística, uma licença criativa explícita, mas os comandos pediam a criação de personagens com delimitações históricas claras: "faça a imagem de um viking", "faça uma imagem do Papa" e assim por diante. O Google reconheceu o erro e suspendeu a criação de imagens de pessoas pela ferramenta. Foi o gatilho para a "guerra cultural" sobre o pensamento woke aterrissar de vez no campo da tecnologia.

Ação e reação: os movimentos woke e anti-woke

O termo woke surgiu no contexto das lutas da comunidade afro-americana contra o racismo e pelo reconhecimento de direitos civis. Estar "acordado" é estar consciente e alerta para os problemas gerados pela injustiça racial.

Mais recentemente o termo ganhou conotações amplas. Passou a se identificar com pautas feministas, ambientais, de proteção à comunidade LGBTQIA+, direitos reprodutivos e toda uma série de preocupações mais usualmente alinhadas ao espectro progressista e politicamente de esquerda. Em 2017, o dicionário Oxford incluiu um verbete sobre o termo, segundo o qual ser woke é "estar consciente sobre temas sociais e políticos, especialmente o racismo".

A reação à cultura woke não tardou. Teve como alvo o fato de o discurso não estar acompanhado de uma prática coerente. Também mirava a ideia de a mudança social desejada poder ser alcançada por outros meios que não a promoção de esforços de inclusão e diversidade, que valorizavam grupos minoritários ou historicamente vulnerabilizados.

O debate chegou às campanhas eleitorais e aos tribunais. Em 2023, a Suprema Corte dos EUA determinou o fim das cotas raciais no ensino superior. Segundo o presidente da Corte, "a cor da pele de uma pessoa não pode desempenhar um papel na avaliação individualizada da mesma em um ambiente de aprendizado diversificado". O sinal estava dado para Estados começarem a passar leis que revertessem programas de inclusão social e de promoção à diversidade.

A Flórida já havia aprovado uma lei que impedia o ensino de questões ligadas à orientação sexual e identidade de gênero no ensino fundamental. Após um executivo da Disney criticar a medida, o Poder Legislativo estadual revogou o status especial que garantia à empresa uma série de benefícios na exploração do terreno em que estão situados os seus parques.

Se a Disney quer comprar uma briga, ela escolheu o cara errado

Ron DeSantis, governador do estado, em e-mail para apoiadores

Os vieses da tecnologia

Nas redes sociais —e em especial no X (antigo Twitter)—, as falhas do Gemini ao criar personagens históricos com uma lente de diversidade e inclusão foram rapidamente vistas como uma tentativa de reescrever o passado. Além disso, comandos que pediam a criação de personagens brancos estavam voltando resultados com diversidade étnica.

Elon Musk, dono do X, e que possui sua própria aplicação de chat com IA (chamada Grok), afirmou que a "bolha burocrática woke" da Google não permitiria que a aplicação fosse eficazmente corrigida, mas que ele estava feliz pelo ocorrido, já que teria sido revelada como a programação da empresa é "insanamente racista e anticivilizacional".

I'm glad that Google overplayed their hand with their AI image generation, as it made their insane racist, anti-civilizational programming clear to all

-- Elon Musk (@elonmusk) February 23, 2024

O uso da expressão "racista" aqui chama atenção. Até o episódio com o Google Gemini, o debate sobre vieses em IA e a questão racial em aplicações que criam imagens e vídeos estava direcionado à predominância de personagens e retratações de pessoas brancas nessas ferramentas. O teste é simples: ao pedir uma imagem a qualquer aplicação de IA, a resposta geralmente retorna personagens brancos.

Newsletter

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

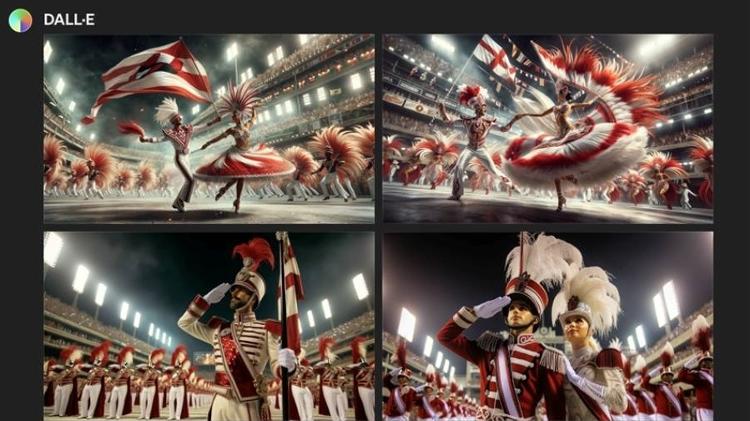

Quero receberSe serve de exemplo, esse é o resultado que obtive no DALL-E, da Open AI, ao solicitar imagens que retratassem o mestre-sala e a porta-bandeira da Acadêmicos do Salgueiro. O desfile da escola de samba pela Sapucaí mais parece uma animada marcha de um exército europeu caucasiano com trajes oriundos das guerras napoleônicas.

O que realmente aconteceu com o Gemini?

Resultados como o acima parecem ter sido o que a Google buscou evitar. Ainda assim, falhou flagrantemente na calibragem. Em publicação no blog da empresa, Prabhakar Raghavan, vice-presidente sênior da Google, apresentou uma explicação para o ocorrido e as medidas adotadas pela empresa. Dois pontos podem ser destacados no seu texto.

- 1) Ele procura desassociar os erros do Gemini dos demais produtos da empresa

[O Gemini] um produto específico separado da Busca, de nossos modelos de IA subjacentes e de nossos outros produtos

Prabhakar Raghavan

O risco aqui é um efeito de contágio dos resultados gerados pelo Gemini sobre a impressão que o público tem de outras aplicações de sucesso, em especial a Busca (que também já foi objeto de críticas sobre vieses nos seus resultados).

- 2) Ele tenta esclarecer o que deu errado.

Resumindo: duas coisas. Primeiro, nosso ajuste para garantir que o Gemini mostrasse um conjunto diverso de pessoas não levou em conta os casos em que claramente não deveria mostrar um conjunto diverso. E em segundo lugar, com o tempo, o modelo tornou-se muito mais cauteloso do que pretendíamos e recusou-se a responder inteiramente a certas solicitações - interpretando erroneamente algumas solicitações muito insignificantes como sendo sensíveis. (...) Essas duas coisas levaram o modelo a compensar excessivamente em alguns casos e a ser demasiado conservador noutros, conduzindo a imagens embaraçosas e erradas.

Prabhakar Raghavan

Aqui vale se perguntar: como chegamos a essa situação? De duas uma: ou a equipe de desenvolvimento da Google, ao testar a ferramenta, não experimentou gerar imagens com personagens históricos ou escrever prompts que pedissem imagens de pessoas com uma etnia específica —o que seria espantoso. Ou a empresa diagnosticou que havia uma tendência a inserir diversidade em resultados em que esse elemento era factualmente errado e decidiu seguir adiante.

Esse segundo cenário talvez tenha sido reforçado pelo fato de outras ferramentas de IA já serem criticadas por falhar em prover resultados mais diversos e inclusivos. O que chama atenção é o volume de críticas que a empresa recebeu, o que forçou a suspensão de seu uso para criar imagens de pessoas.

Por um lado, não custa lembrar. Enquanto diversas aplicações de IA falharam em representar pessoas negras, as críticas não levaram à adoção de medidas drásticas. Agora que as não representadas são pessoas brancas, parece que o jogo é outro. De qualquer forma, a situação do Google possui uma peculiaridade: o Gemini estava falhando em dar resultados não diversos mesmo quando os comandos pediam uma imagem de pessoa de uma certa raça ou etnia.

Qual será o legado do episódio do Google Gemini?

Ao final, o episódio com o Google Gemini talvez fique marcado como o momento no qual as empresas de tecnologia passaram a ver no front do desenvolvimento de IA o mesmo dilema enfrentado com a moderação de conteúdo. Alguns dizem que redes sociais retiram conteúdo demais, explicitando sua visão progressista e calando vozes conservadoras. Outros dizem que as mesmas empresas removem de menos, deixando no ar conteúdos problemáticos.

O mesmo cabo de guerra chega ao campo da IA. Um espectro do debate público vai dizer que os resultados de IA promovendo diversidade estão forçando um discurso woke e impondo visões progressistas da empresa. É a confusão entre censura e moderação de conteúdo, já existente nas redes sociais e que chega à geração de imagens por IA. Por outro lado, empresas com menos moderação sobre conteúdos gerados por IA serão criticadas por permitir a criação de conteúdos potencialmente danosos.

Esse talvez seja o legado mais duradouro do episódio envolvendo o Google Gemini. Mais do que uma guerra cultural propriamente dita, o caso parece ter mostrado os processos de desenvolvimento e lançamento de aplicações que geram conteúdo com IA.

Como vivemos e vamos viver progressivamente em mundo repleto por esse tipo de criação, é cada vez mais importante entender os bastidores daquilo que se vê. René Descartes (1596-1650) dizia que os sentidos são traiçoeiros. Mal sabia ele.

Deixe seu comentário