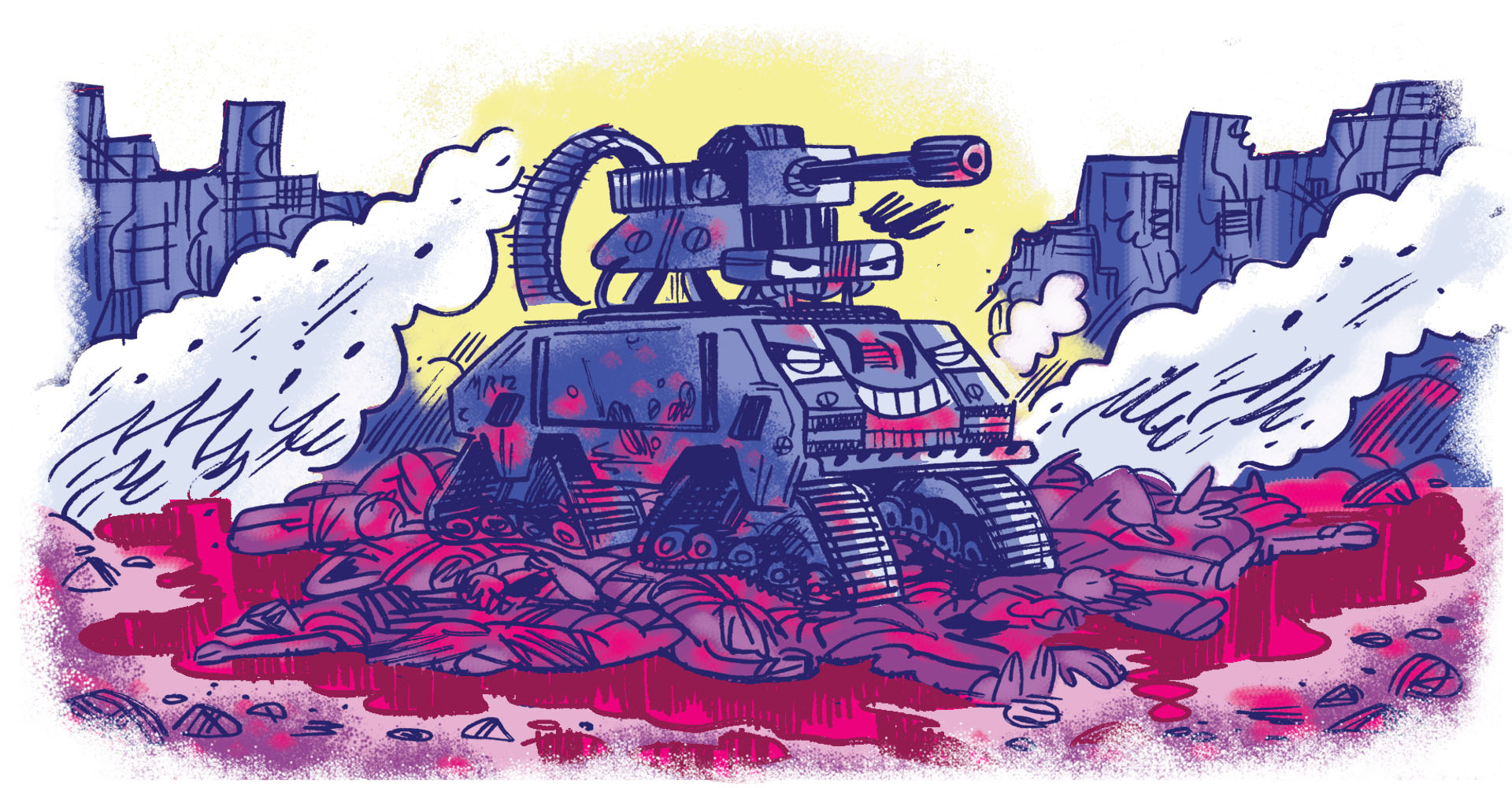

Um drone programado para reconhecer alvos e atirar automaticamente. Ataques hackers que acabam com a luz de hospitais e derrubam a energia de uma base militar. Soldados equipados com óculos de realidade virtual que conseguem detectar o inimigo sem dificuldades.

Parece filme de ficção, mas já chegamos nesse ponto dos avanços bélicos. Estamos falando de uma onda de recursos tecnológicos que será experimentada em contextos onde ainda não há regras específicas —o que dificulta, por exemplo, que países saibam o que é um ataque (e o que envolverá retaliação).

Os fóruns onde essas novas armas deveriam ser discutidas seguem estruturalmente incapazes de lidar com a "evolução exponencial" das aplicações militares. E, enquanto soluções não surgem, o cenário é de caos.

A guerra da Rússia contra a Ucrânia é o exemplo mais recente de como tecnologias podem ajudar a definir quem ganha e quem perde batalhas. Drones ajudaram, por exemplo, a atrasar o avanço das tropas russas em Kiev, capital da Ucrânia. O caça da Rússia Sukhoi Su-57, desenvolvido com tecnologia de última geração e que não pode ser detectado por radares, foi usado pela primeira vez em um conflito do tipo.

E a Guerra 2.0 vai muito além...

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.