Deepfakes de Taylor Swift mostram o desafio que o TSE tem para as eleições

Imagens sexuais falsas de Taylor Swift invadiram as redes sociais na última semana. E não foi a primeira vez que a superestrela sofreu com esse tipo de conteúdo. No fim do ano passado, vídeos falsos da cantora vendendo panelas viralizaram no TikTok. Tudo fake. Tudo criado por IA.

A popstar americana não é a única que teve sua imagem violada por criminosos. No Brasil, vídeos falsos de vários famosos circularam como propaganda de produtos duvidosos. Drauzio Varela e Pedro Bial estrelaram campanhas falsas de vitaminas e remédios para calvície.

A proliferação desse tipo de conteúdo é impulsionada pelo avanço da IA generativa, e tudo isso está acontecendo em um momento em que a democracia vai ser colocada à prova. Neste ano, quase metade da população mundial vai às urnas. Brasil, EUA, Índia, México, Indonésia são apenas alguns dos países que terão eleições.

É um momento sensível para entendermos o impacto que a IA terá no processo democrático. Existe uma preocupação global sobre os riscos que os conteúdos criados pela IA podem causar para enfraquecer democracias por meio da manipulação da realidade.

Há muitos anos, estamos pesquisando e discutindo sobre os efeitos das fake news na polarização e no manejo da opinião pública. Só que agora, a coisa fica ainda mais dramática porque estamos lidando com conteúdos mais realistas.

Se antes as fake news focaram muito na produção de notícias falsas e manchetes toscas em formato de meme, agora a coisa ganha contornos que deixam mais difícil distinguir o que é fato do que é fake.

Eu tenho dito que entramos na era da desinformação ultrarrealista.

Pode ser o vídeo de um jornal na TV que nunca existiu. O áudio de um candidato dizendo algo que ele nunca disse. Ou até mesmo um chatbot que se passa por alguém de carne e osso. A IA generativa traz tantas possibilidades para a fabricação de realidades que eu nem conseguiria listar todas aqui.

Por este motivo, o TSE está atento para a situação. No dia 4 de janeiro, o tribunal divulgou uma minuta das resoluções para as eleições municipais de 2024, que estão sendo discutidas em audiências públicas.

Em um dos textos, o tribunal estabelece que os conteúdos para campanhas que sejam fabricados ou manipulados por IA devem ser acompanhados de uma informação explícita em destaque que foi criado ou editado pela tecnologia, além de destacar qual foi utilizada.

Alguns ativistas e pesquisadores criticaram a decisão dizendo que isso confundiria ainda mais os cidadãos, além de abrir espaço para a construção de realidades paralelas.

Só que em um outro trecho, a minuta proíbe a utilização de desinformação na propaganda eleitoral e impõe responsabilidades ao provedor de aplicação para impedir ou diminuir a circulação de conteúdo.

Não sou jurista, mas na minha interpretação, isso já seria o suficiente para proibir conteúdos sintéticos com objetivo de enganar, sejam eles criados ou não por IA.

Precisamos ter cautela para não atribuir apenas malefícios para uma determinada tecnologia. Apesar de eu achar que as deep fakes são traças tecnológicas que corroem o tecido social, é preciso entendermos que IA não é sinônimo de deep fake.

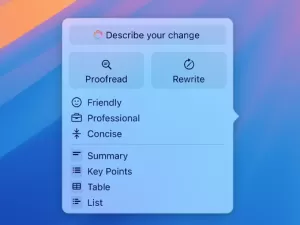

A IA é muito mais ampla e pode ter diferentes usos. Em uma campanha política, pode ser usada para revisar conteúdos ou para construir peças publicitárias que sejam criativas, com menor custo e que nada tenha a ver com a produção de deep fakes.

Newsletter

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Quero receberNas eleições argentinas, a campanha do candidato Sergio Massa utilizou IA para produzir um vídeo do navio do exército argentino sendo atingido por disparos do submarino britânico, uma resposta para as falas do candidato Milei. Um conteúdo criativo que, produzido ou não por IA, estaria dentro das regras do jogo.

O que o TSE tem pela frente é que a IA impõe um desafio com muitas dimensões, que muitas vezes não é debatido com profundidade.

Sempre que aparece alguma notícia envolvendo deep fakes, não faltam pedidos para regulação da tecnologia.

Acho que é importante discutirmos como regular a IA, mas quando estamos agindo sobre deep fakes, uma regulação ajudaria, mas não resolveria todo o problema.

Precisamos entender que o desafio de governança sobre conteúdos sintéticos fabricados por IA envolve duas principais dimensões: a criação e a distribuição.

Hoje, os modelos de IA generativa se dividem em dois principais tipos: os comerciais (proprietários) e os de código aberto.

Os usuários que produzem deep fakes com o objetivo de aplicar golpes ou manipular a opinião pública, geralmente utilizam ferramentas alternativas, muitas vezes de código aberto, e não serviços comerciais oferecidos pelas bigtechs, que já implementam travas de segurança para impossibilitar —ou pelo menos dificultar— que conteúdos prejudiciais sem gerados.

Em matéria do "The New York Times", é citado que uma empresa de cibersegurança focada em detecção de IA, determinou com 90% de confiança que as imagens sexuais de Taylor Swift foram criados por "Diffusion Models". Essa é uma tecnologia que está disponível ao público em versões de código aberto que podem ser modificadas.

Neste caso, mesmo uma regulação de IA bastante restritiva, que chegasse ao extremo de banir as ferramentas de criação de imagens, não alcançaria quem, de fato, está causando o problema. Grupos organizados continuariam utilizando meios próprios, baseado em ferramentas alternativas, para produzir conteúdos danosos.

Então, além de olhar para a produção, precisamos estar atentos para a distribuição. Não adianta nada alguém produzir um conteúdo se não tiver caminhos para alcançar o máximo número de pessoas.

Mas as coisas também não são simples nessa dimensão.

Hoje, os principais meios de distribuição são os serviços de grandes plataformas e de redes sociais. Uma das imagens da Taylor Swift foi vista mais de 47 milhões de vezes no X (antigo Twitter) antes de ter sido deletada pela empresa.

As grandes plataformas estão sofrendo escrutínio público e pressão para criar mecanismos que identifiquem e moderem conteúdos criados por IA.

Recentemente, o Pedro Bial acusou a Meta (dona do Facebook, Instagram e Whatsapp) de ser cúmplice no caso de suas deep fakes.

"Então hoje eu acuso, acuso de cumplicidade nesse crime de falsificação, fraude e charlatanismo a Meta, empresa dona do Instagram e do Facebook. Eu acuso! Pois é um crime. E um crime para se realizar precisa de três fatores: a motivação para praticá-lo, mais os meios e oportunidades para tal. Pois bem, se a motivação é dos mercadores do falso remédio, o meio e as oportunidades são oferecidas pela Meta, que ainda lucra, ganha grana com esse golpe."

No lugar do Bial, eu também estaria revoltado, mas o problema é muito maior. Não dá para isentar as plataformas de toda a culpa, mas existe uma dificuldade técnica muito grande em como proteger os usuários de conteúdos sintéticos.

No caso da Taylor Swift, o X precisou bloquear buscas pelas palavras "Taylor Swift" ou "Taylor Swift AI" para evitar que os usuários conseguissem acessar o conteúdo malicioso, tudo porque a rede social ainda não dispõe de um mecanismo que identifique e modere conteúdo sintéticos.

Esse é um dos empecilhos para a governança. Hoje, não existem formas automáticas e confiáveis para detectar conteúdos criados por IA. Grupos de pesquisas ao redor do mundo e os próprios laboratórios das empresas estão debruçados em como criar técnicas para prover marcas d'águas e metadados em conteúdos sintéticos.

O desafio, além de técnico, também envolve uma questão de ecossistema. É preciso que todos os atores estejam alinhados em usar os mesmos padrões.

Não adianta nada uma empresa que desenvolve IA utilizar uma técnica de marca d'água que não seja a mesma utilizada pelas plataformas. Existem alguns consórcios, como é o caso o da "The Coalition for Content Provenance and Authenticity (C2PA)", que reúne empresas de diferentes segmentos para criar padronizações para prover formas de autenticidade para conteúdos.

Existem outras iniciativas também, mas ainda não estamos tão próximos de chegar a uma solução final, até porque diferentes tipos de conteúdos (imagens, textos, áudio, vídeos) vão demandar técnicas específicas. Lembro que até hoje não existe nenhuma ferramenta confiável que identifique se um texto foi escrito pelo ChatGPT. Até a OpenAI, criadora do chatbot, aposentou uma ferramenta que fazia algo do tipo por não ser confiável.

Queria trazer uma mensagem positiva que conseguiríamos resolver a questão com regulações e um esforço técnico ainda neste ano, mas vocês devem ter entendido a complexidade da situação.

Não tenho dúvidas que campanhas ao redor do mundo —ou apoiadores independentes— já estejam planejando uma produção maciça de conteúdos de IA. É provável que você e eu sejamos impactados por um conteúdo sintético antes de apertarmos os botões da urna, que poderá ser deep fake ou uma peça publicitária.

O ano promete ser de muito aprendizado sobre governança de IA, e certamente voltarei ao tema nesta coluna.

Deixe seu comentário