Está fazendo sucesso em Nova York uma máquina que usa inteligência artificial para fazer leituras astrológicas. Com um botão de girar, as pessoas escolhem entre cem perguntas existenciais, como "Devo começar meu próprio negócio?", "Como devo gastar meu tempo?" ou até mesmo "Devo guardar dinheiro ou o mundo vai acabar antes disso?".

Depois é só entrar com a data e lugar de nascimento para a máquina cuspir um pequeno pedaço de papel com a resposta. Tudo baseado em cálculos astrológicos, reforça uma mensagem na tela do dispositivo. É uma situação inusitada, mas que me fez pensar em como a IA é uma excelente ferramenta para reproduzir um monte de pseudociência que vemos por aí.

Apesar de cético, eu não estou aqui para jogar pedra em astrologia. Acho interessante como uma área que começou com um propósito científico acabou sequestrada pelo misticismo. E é importante entender como o misticismo gera conforto mental nas pessoas. Talvez a ciência um dia nos ajude nisso - ou os astros, quem sabe.

A astrologia funciona bem porque está sempre disposta a nos falar o que precisamos ouvir - ou o que achamos que devemos ouvir e, de uma forma que parece ser particular para cada um.

A ciência por trás do "essa foi para mim"

Quando eu digo que ela funciona, não estou afirmando que ela está certa ou que acerta, mas que cumpriu o seu papel: deu respostas em que as pessoas acreditam. A gente sabe que uma boa leitura astrológica é aquela que alguém diz, "essa foi para mim". E, acredite, a ciência já catalogou o fenômeno: Efeito Forer.

O Efeito Forer demonstra a nossa tendência de aceitar narrativas generalistas como se fossem feitas especificamente para nós. Esse fenômeno foi inicialmente investigado por Bertram R. Forer, que entregou aos seus alunos uma análise da personalidade de cada um. Em seguida, pediu para eles avaliarem quanto a descrição estava correta.

A maioria achou a avaliação muito boa, como se o autor os conhecesse intimamente. Só que tinha um problema.

Todos eles receberam exatamente o mesmo conteúdo. E, mesmo assim, cada um encontrou pontos que se conectavam com o jeito de ser deles. Julgaram um discurso genérico como se fosse a história da sua vida.

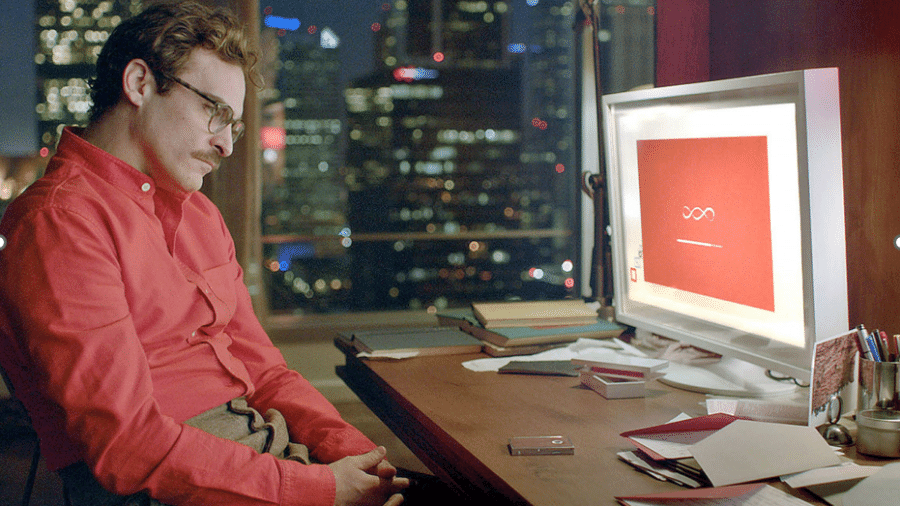

Muitos pesquisadores veem no Efeito Forer a chave do sucesso da astrologia. Acho, porém, que o fenômeno é um incentivo para estudarmos a interação entre humanos e máquinas a partir de diferentes abordagens, ainda mais com o surgimento de tecnologias que dominam a linguagem.

Se confiarmos cegamente na IA, podemos ser influenciados por uma ferramenta que constrói possibilidade e repostas a partir de uma base de conhecimento que pode não ter nada de científico.

O ChatGPT é uma tecnologia com enorme potencial para gerar narrativas generalistas e produzir respostas convincentes, ainda que sem qualquer compromisso com a realidade. Um dos efeitos colaterais são as alucinações, que acontecem quando o modelo gera uma resposta com fatos inexistentes ou que não têm nada a ver com a realidade.

Se uma pessoa desavisada e não especializada em um tema fizer uma pergunta, terá dificuldade de identificar erros e imprecisões em uma resposta persuasiva elaborada pela máquina. E o fato de chamarmos a coisa de Inteligência Artificial faz o público geral projetar uma confiança ainda maior.

Um dos maiores perigos da IA

O problema da IA não é apenas ela estar errada, mas ela estar errada e mesmo assim nos convencer que está certa.

Isso vale para modelos de linguagem, como o ChatGPT, mas também para ferramentas mais especializadas. Eu trabalho há alguns anos com computação afetiva, uma área que desenvolve sistemas de IA para detectar e representar emoções humanas a partir de diferentes entradas: linguagem, dados fisiológicos, neurais, expressão facial e outros.

Sempre foquei em trabalhar com a linguagem, ou seja, desenvolver modelos que reconhecem expressões emocionais em texto. Porém, os sistemas de Computação Afetiva que mais fazem sucesso são aqueles que dizem reconhecer a emoção na expressão facial.

Esta é uma tecnologia que se vende fácil. Com uma câmera em tempo real, o sistema marca na tela os rostos das pessoas e classifica se elas estão tristes, felizes, ansiosas etc. É uma interface tentadora que desvenda a intimidade afetiva de qualquer um que passar por ela.

Só que a coisa não é bem assim. As evidências científicas mais recentes demonstram que não é possível inferir o estado mental de uma pessoa (por exemplo, uma emoção) usando apenas a expressão facial.

No último Internet Governance Forum da ONU, eu organizei um painel sobre o tema. Junto de neurocientistas, pesquisadores e representantes de bigtechs, concluímos que usar o reconhecimento facial para inferir a emoção de alguém pode apresentar riscos para a autonomia e decisão das pessoas. Portanto, esse uso deveria ser evitado.

A Microsoft, que tinha um dos principais sistemas e participou do painel, está de acordo. Recentemente, ela aposentou a sua tecnologia sob o argumento de que não há evidência científica de que é possível reconhecer a emoção de alguém usando apenas a expressão facial, ainda mais em um sistema global usado por diferentes regiões e culturas do mundo.

Um modelo de IA sempre vai produzir uma resposta de acordo com os dados com que ele foi treinado. Se os dados forem enviesados ou provenientes de uma abordagem pseudocientífica, o sistema vai reproduzir esse tipo de comportamento na sociedade - só que de uma maneira rápida e persuasiva.

A mentalidade "tecnosolucionista" está fazendo o pessoal acreditar que a IA pode resolver todos os problemas, inclusive aqueles que nem existem. Hoje tem um monte de sistema criado para coisas que não fazem o menor sentido. Recentemente, vi uma IA treinada para identificar a orientação sexual de alguém com base na sua imagem. Outro dia, foi um modelo que reconhece a ideologia dos cidadãos usando somente fotos.

Tudo isso é pseudociência embutida em uma máquina de fazer inferência.

O problema é que se esse tipo de tecnologia começar a ser usada em decisões sensíveis, como recrutamento ou imigração, entraremos em uma sociedade distópica em que máquinas influenciam decisões sobre as pessoas com base em nada.

A IA pode trazer muitas contribuições para a humanidade, mas precisamos entender como ela foi treinada e em quais circunstâncias será usada. Caso contrário, podemos ter os nossos comportamentos influenciados mais por máquinas pseudocientíficas do que pelos astros.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.