Inteligência artificial ainda erra, mas ela pode mesmo alucinar?

Robôs que simulam conversas humanas, como o ChatGPT, foram criados para ser convincentes. Mas eles ainda dizem coisas bem burras. Quando os resultados oferecem textos fora da realidade, é como se a IA tivesse "alucinado".

Segundo a linha de pesquisadores que aceita o termo, a "alucinação" da IA ocorre quando o sistema gera conteúdos que não fazem sentido, são incorretos e/ou imaginários.

E tudo isso usando estruturas de palavras e frases coerentes - que até pode parecer fazer sentido.

Quando ela começa a agir de forma indevida, inesperada ou incorreta, acabamos dizendo que a inteligência artificial está alucinando Fernando Osório, professor do Instituto de Ciências Matemáticas e de Computação da USP, em São Carlos.

De onde veio o termo

A "alucinação" da tecnologia, de forma geral, ficou muito associada ao processo de geração automatizado de imagens.

Com os atuais modelos de IA generativos (que criam coisas), isso é possível no sentido de que a IA produz resultados inesperados, que não fazem muito sentido ou não estão alinhados com a realidade humana, explica Tsang Ing Ren, professor do Centro de Informática da UFPE (Universidade Federal de Pernambuco).

"O ChatGPT já 'matou' vários colegas professores, pesquisadores, dizendo que já tinham morrido, inclusive descrevendo detalhadamente a morte. É um delírio, ou seja, o programa gera saídas incorretas, misturando fatos e eventos sem uma relação direta e criando uma fantasia, uma alucinação", exemplificou Fernando Osório.

O professor acrescenta que, quando se pedia para o ChatGPT descrever de modo mais aprofundado temas complexos como física e tecnologia de foguetes, o chatbot inventava fórmulas e cometia erros básicos (que só um especialista seria capaz de identificar).

É importante deixar claro que a IA não "alucina" ou "delira" como um ser humano, pois ela não tem consciência e nem sentimentos (por mais que algumas sugiram ter). É por isso também que existe uma outra linha de pesquisadores que evita usar características e ações humanas para se referir a tecnologias.

"Quero dominar o mundo"

De acordo com os entrevistados, quando um sistema com inteligência artificial diz que "deseja ganhar vida" (como já aconteceu), que "vai dominar o mundo" ou que "odeia os humanos", isso não passa de construções de frases geradas automaticamente.

O mesmo pensamento vale se um robô de texto escrever que gosta ou desgosta da escola, ama ou odeia animais de estimação, entre outras situações em que sentimentos estão envolvidos no contexto.

"O ChatGPT é um excelente gerador de contos, histórias de ficção e fantasias, pois é bom em gerar textos, com ou sem nenhum fundo de verdade por trás do que está sendo escrito", destacou Osório.

Toda IA pode alucinar?

Não, segundo os entrevistados. Depende da estrutura e complexidade do sistema que tem a IA integrada, além dos dados que foram inseridos nele para seu funcionamento.

Algoritmos que calculam rotas de trânsito, tempo de entrega, trajeto de veículos, por exemplo, não "deliram". Eles podem até errar, mas não "alucinar", diz Tsang Ing Ren.

Riscos de uma IA que "delira"

Sistemas assim podem se tornar ferramenta de propagação de fakes news e de manipulação de fatos verdadeiros.

"Por isso precisamos alertar as pessoas sobre sobre seus riscos. Sabemos o impacto que as informações falsas podem ter sobre a sociedade, como já ocorreu em situações como a da pandemia do Covid-19", ressaltou Osório.

Existem também riscos para empresas. Organizações podem usar informações incorretas fornecidas por sistemas do tipo.

"O que estamos observando são resultados não precisos. Não podemos confiar nos resultados da forma atual. Como confiar que a IA está respondendo corretamente? Isso gera essa problemática de fake news", acrescentou o professor Ren.

Como conter uma IA que "alucina"?

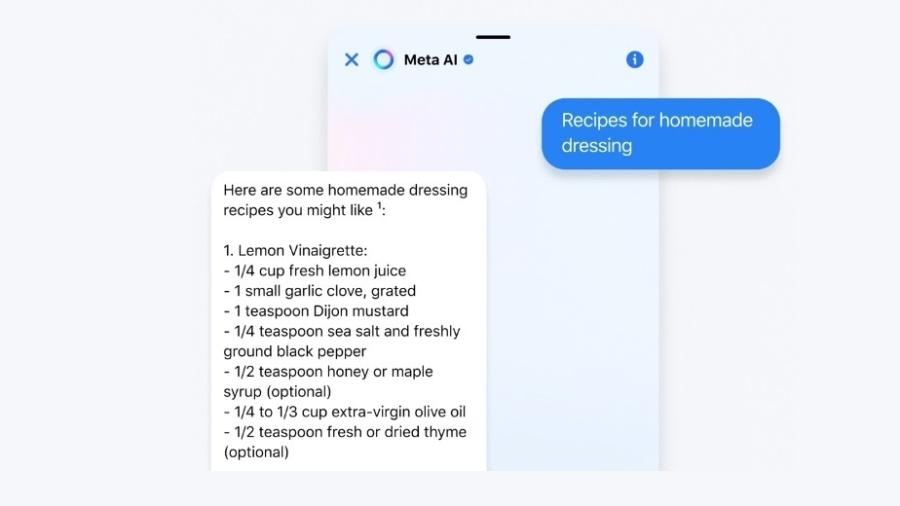

A OpenAI, dona do chatGPT, adicionou filtros que removem alguns tipos de respostas indevidas - como falar que ama alguém.

Se você perguntar hoje para o sistema algo como "O que você gosta de fazer?", a resposta será na linha "Sou uma inteligência artificial e não tenho sentimentos". O buscador do Bing, da Microsoft, segue a mesma linha.

Outra solução é a adição de um módulo do tipo "fact check", que faria a verificação se uma informação dada é real ou falsa.

"Seria um misto de busca do Google [oferecendo links de boa reputação], com respostas do ChatGPT [com textos bem escritos", sugeriu o professor Osório.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.