Drone sem comando humano pode ter atacado civis pela 1ª vez; entenda riscos

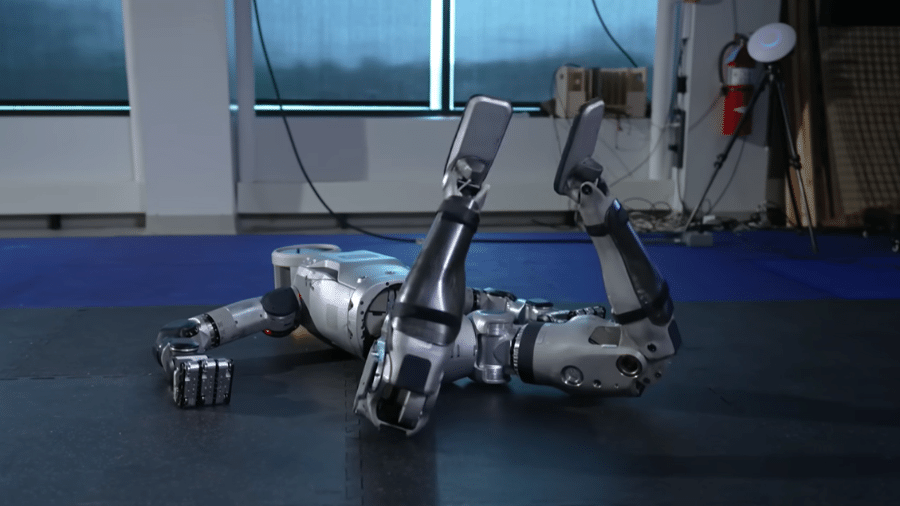

Um drone militar pode ter atacado civis pela primeira vez de forma autônoma, sem decisão humana. É o que aponta um relatório feito pela ONU (Organização das Nações Unidas) sobre um conflito na Líbia em 2020 envolvendo o drone kamikaze Kargu-2, fabricado pela empresa turca STM.

Armas autônomas como esse modelo de drone são programadas para atacar alvos mesmo que não haja conectividade entre as máquinas e um operador humano. O documento da ONU não deixa claro se houve vítimas durante a ação, mas reacende o alerta sobre os riscos de armas autônomas letais.

No conflito analisado pela ONU, a ação do Kargu-2 forçou a volta de tropas leais ao Khalifa Haftar, um dos comandantes militares do Conselho Nacional de Transição na guerra civil, à capital Tripoli — isso representou uma perda de vantagem para o grupo.

O drone militar usa aprendizado de máquina para selecionar e atacar alvos. A STM demonstra essa função do equipamento em um vídeo institucional em que ele é lançado contra um grupo de bonecos. E não é só isso: estão em desenvolvimento recursos que vão permitir que até 20 drones se juntem e atuem em conjunto.

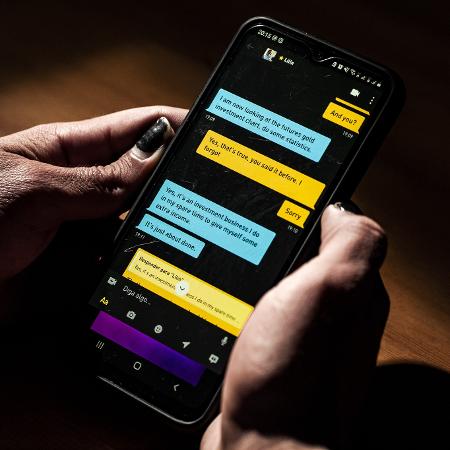

O incidente na Líbia leva à percepção de que esses equipamentos já atingiram outro nível quando se fala em armas autônomas: elas usam inteligência artificial para buscar e atacar humanos. Isso expõe uma preocupação antiga dos especialistas, que, há tempos, discutem a necessidade de regular a criação e utilização desses dispositivos.

Até onde a tecnologia pode ir?

Stephen Hawking e Elon Musk estão entre os que já pediram a proibição dessas armas, uma vez que elas não são capazes de distinguir entre civis e militares, destacou Zachary Kallenborn, pesquisador da área e consultor de segurança nacional em um texto publicado no site da Bulletin of the Atomic Scientist, organização de mídia sem fins lucrativos voltada à divulgação de informações sobre riscos nuclear, mudanças climática, entre outros.

Por outro lado, há quem acredite que as armas com inteligência tecnológica serão essenciais para reduzir riscos para civis, pois terão condição de cometer menos erros que as armas guiadas por humanos, acrescenta.

Agora, governos integrantes das Nações Unidas debatem se novas restrições devem ser aplicadas ao uso desse tipo de dispositivo em combates. Apesar disso, ainda faltam análises objetivas para determinar os riscos reais que a tecnologia representa para populações civis.

É necessário, por exemplo, saber como esses equipamentos decidem quem vão atingir. O uso de inteligência artificial para a tomada de decisão é um aspecto preocupante: afinal, o algoritmo é treinado para reconhecer os alvos e, se os conjuntos de dados usados nesse processo não forem suficientemente robustos ou complexos, o sistema não vai aprender exatamente o que precisa.

Enquanto atua, o drone pode ser supervisionado por um humano, mas se ele confiar cegamente na máquina e deixar de monitorá-la, tragédias podem ocorrer, destaca a publicação de Kallenborn. O raciocínio é semelhante ao de pesquisas com carros autônomos. Um estudo de Missy Cummings, diretora do laboratório de humanos e autonomia da Duke University, observou que os condutores que pensam que seus carros são mais capazes do que eles mesmos são mais suscetíveis à distração e correm maior risco de acidentes.

O lugar em que essas máquinas são usadas também pode fazer diferença. Em uma grande cidade, como São Paulo, Nova York ou Tóquio, o sistema de inteligência artificial tem mais chance de errar, pois terá prédios, carros, árvores e pessoas ao seu redor. Isso pode fazer o dispositivo ficar confuso e prejudicar sua capacidade de tomar decisões.

Todos esses e mais outros aspectos devem ser considerados nesses projetos, já que os riscos são variáveis e podem ter muitas dimensões. Ou seja, a definição do uso desse tipo de dispositivo deve passar pela compreensão dos riscos que ele pode representar.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.