Após denúncia de viés racista, Twitter diz que vai revisar algoritmo

Mirthyani Bezerra

Colaboração para Tilt

21/09/2020 12h18

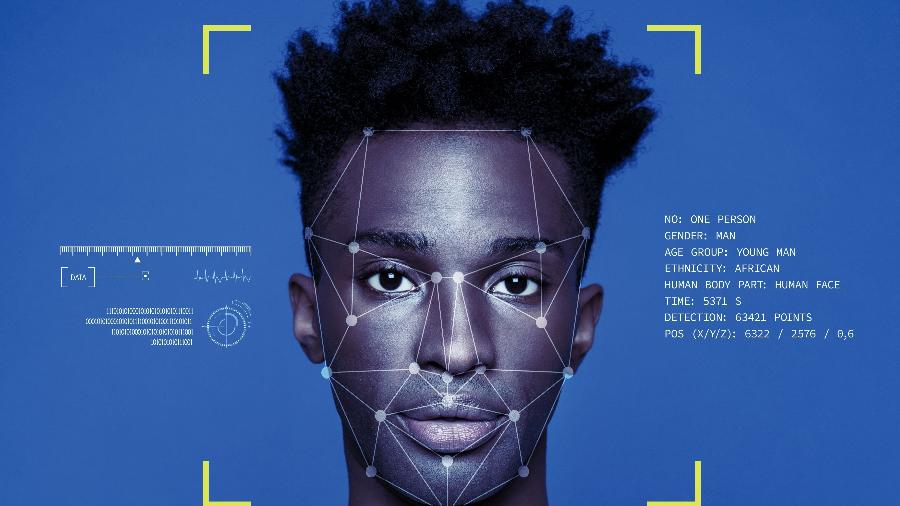

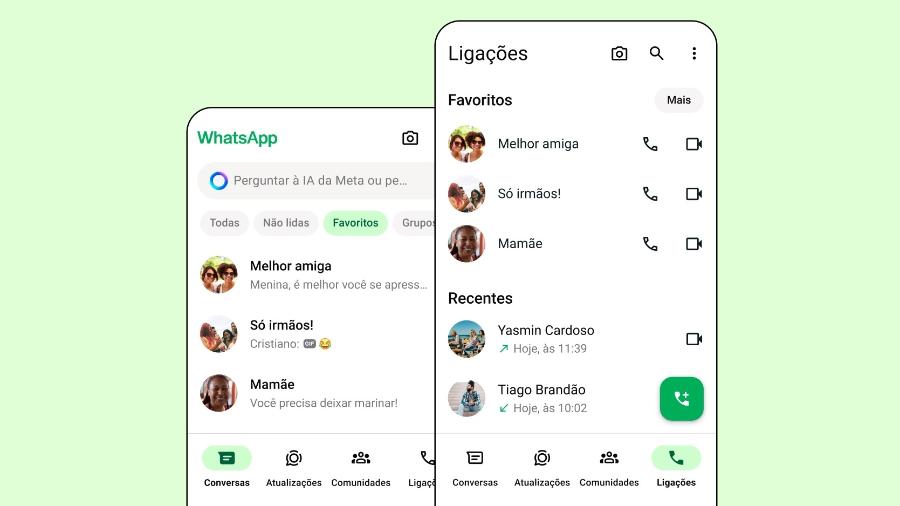

O Twitter está investigando por que sua rede neural para gerar visualizações de fotos aparentemente opta por mostrar imagens de pessoas brancas com mais frequência do que rostos negros. A suspeita foi apontada por usuários da rede social ao longo do fim de semana.

Eles postaram vários exemplos de postagens com o rosto de uma pessoa negra e de uma branca para provar que a prévia do Twitter mostrava rostos de brancos com mais frequência. Os usuários também descobriram que o algoritmo de visualização da rede social escolhia mais personagens de desenhos animados não negros.

Trying a horrible experiment...

-- Tony "Abolish (Pol)ICE" Arcieri (@bascule) September 19, 2020

Which will the Twitter algorithm pick: Mitch McConnell or Barack Obama? pic.twitter.com/bR1GRyCkia

Um usuário tentou postar sobre um problema percebido por ele no reconhecimento facial de Zoom, que não mostrava o rosto de um colega negro nas ligações. Quando ele postou no Twitter, também percebeu que a plataforma favorecia o seu rosto branco em vez do rosto de seu colega negro.

A faculty member has been asking how to stop Zoom from removing his head when he uses a virtual background. We suggested the usual plain background, good lighting etc, but it didn't work. I was in a meeting with him today when I realized why it was happening.

-- Colin Madland (@colinmadland) September 19, 2020

O Twitter disse que testou vieses raciais e de gênero durante o desenvolvimento do algoritmo. Mas acrescentou: "É claro que temos mais análises a fazer."

"Testamos esse viés antes de enviar o modelo e não encontramos evidências de preconceito racial ou de gênero em nossos testes. Mas está claro que temos mais análises para fazer. Continuaremos a compartilhar o que aprendemos, quais ações tomamos e abriremos o código para que outros possam revisar e replicar", afirmou a plataforma por meio da sua conta no Twitter.

We tested for bias before shipping the model & didn't find evidence of racial or gender bias in our testing. But it's clear that we've got more analysis to do. We'll continue to share what we learn, what actions we take, & will open source it so others can review and replicate.

-- Twitter Comms (@TwitterComms) September 20, 2020

O diretor de tecnologia do Twitter, Parag Agrawal, disse ter gostado de ver o escrutínio dos usuários e disse estar ansioso para aprender com ele.

"Esta é uma pergunta muito importante. Para resolver isso, nós analisamos o nosso modelo quando o enviamos, mas ele precisa de melhoria contínua. Eu amo este teste público, aberto e rigoroso, e estou ansioso por aprender com ele", afirmou em postagem no Twitter.

This is a very important question. To address it, we did analysis on our model when we shipped it, but needs continuous improvement.

-- Parag Agrawal (@paraga) September 20, 2020

Love this public, open, and rigorous test -- and eager to learn from this. https://t.co/E8Y71qSLXa

As redes neurais artificiais, tal qual as usadas pelo Twitter, por exemplo, são modelos computacionais que se inspiram no sistema nervoso central de um animal, fazendo com que a máquina não apenas seja capaz de aprender, mas de reconhecer padrões.

Especialistas têm alertado que a inteligência artificial poderá contribuir para perpetuar preconceitos se as empresas não prestarem atenção aos dados usados para alimentá-la. Muitos preconceitos podem ser importados nesse processo.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.