Proteção de dados deve ser regulada globalmente, diz historiador

O mundo vive uma revolução impulsionada pela inteligência artificial e os governos devem adotar medidas para proteger os cidadãos dos riscos e das possíveis consequências negativas da adoção dessa tecnologia. Esse foi o alerta do historiador Yuval Noah Harari na conferência de encerramento da 5ª Semana de Inovação, evento promovido pela Escola Nacional de Administração Pública (Enap) nesta semana em Brasília.

Harari é professor da Universidade Hebraica de Jerusalém e autor de best-sellers mundiais como "Sapiens: uma breve história da humanidade" e "Homo Deus: uma breve história do amanhã". O historiador e filósofo discute os cenários do futuro possível da humanidade e os riscos associados ao desenvolvimento de novas formas de organização social, especialmente aqueles relacionados a novas tecnologias como a inteligência artificial (IA).

Segundo o acadêmico, as autoridades públicas precisam empreender esforços para proteger os cidadãos em um conjunto de desafios. O primeiro deles diz respeito ao futuro do trabalho. A IA e a automação devem reconfigurar profundamente os mercados, com potencial para fazer desaparecer boa parte dos empregos atuais e criar novos ofícios. Contudo, não está claro se haverá uma substituição em número suficiente para evitar uma crise de desemprego.

Harari acredita que o problema vá além. Até 2050, pode haver inclusive surgimento e desaparecimento de atividades laborais em curtos prazos. Isso demandará uma capacidade de requalificação dos trabalhadores, de modo a trocar de atividade mais de uma vez ao longo de sua vida. Esta seria uma tarefa chave dos governos. Enquanto no século XX as políticas públicas de educação foram moldadas para os jovens, no século XXI elas deverão contemplar também os adultos.

"Não estamos perto do potencial pleno da IA, mas no começo. Será uma cascata de inovações. Vamos ter ondas de automação em 2035, 2045. Pessoas vão ter que se reinventar repetidamente em suas vidas e os governos vão ter que participar e ajudar as pessoas a gerir suas vidas nos períodos de transição, por meio do pagamento do retreinamento", projeta.

O professor israelense citou o caso do setor de transportes como exemplo dos riscos de devastação de empregos e concentração de poder econômico. Com a ascensão de plataformas como Uber e com a implantação de carros autônomos, o que hoje é uma miríade de pequenos serviços de transporte privado pode se concentrar em poucas corporações.

Divisão internacional

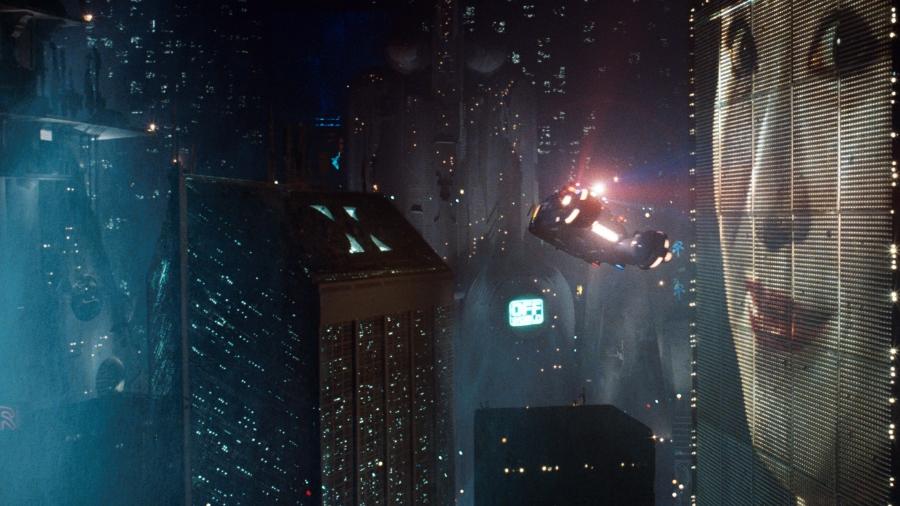

O historiador vê a possibilidade da IA potencializar não apenas desigualdades entre classes, mas entre países. Ele lembrou que a corrida pelo desenvolvimento desta tecnologia tem hoje Estados Unidos e China bem avançados e outros países com muito menos capacidade de produção. Este cenário seria equiparado à Revolução Industrial no século XIX, quando o Reino Unido estabeleceu uma vantagem competitiva sobre o restante do mundo.

Quem mais pode sofrer com essa diferença, acrescentou, são os países em desenvolvimento. Enquanto no século XX essas nações puderam gerar riqueza ao oferecer força-de-trabalho mais barata, em um cenário de intensa automação as regiões periféricas podem sofrer o que o autor chama de uma nova forma de colonização.

"Os dados agora são a matéria-prima. O impacto da IA no mercado será diferente em países distintos. O resultado pode ser que a maioria dos países podem ser colonizados no âmbito do uso de dados pelos líderes da revolução de IA. A automação pode levar a uma nova forma de imperialismo. Vai haver mais trabalhos para engenheiros de software na Califórnia, mas menos para caminhoneiros em Honduras", comentou.

Perigos políticos

Um segundo grupo de perigos diz respeito aos processos políticos. Harari estimou que a combinação de bioengenharia, poder computacional e coleta e tratamento de dados permitiriam uma prática que o historiador caracterizou como "hackear os seres humanos". Ao possuírem informações biométricas e comportamentais das pessoas, governos e corporações controladores destes dados e de capacidade tecnológica conseguiriam saber mais sobre os indivíduos do que eles mesmos, o que poderia ser empregado para manipulação de sentimentos e atitudes e tomada de decisões.

"Um algoritmo pode dizer a orientação sexual de um adolescente somente rastreando movimentos do olho. Talvez até eu não saiba que sou gay, mas a Coca Cola saiba. Na próxima vez que mostrar uma publicidade, vai mostrar com homem e não com mulher, me fazendo escolher este produto. E essa informação vai valer bilhões. Mas vai ter outras consequências, também. Em alguns países há penas de morte por homossexualidade", exemplificou.

O professor ponderou que os governos terão de resistir à tentação de montar máquinas de vigilância, pois o uso delas "pode gerar os regimes mais totalitários já vistos". Mais do que apenas não atuar desta maneira, os governos devem proteger seus cidadãos das corporações que operam coletando dados e influenciando condutas dos indivíduos. Para isso, sugeriu, é necessário regular a propriedade dos dados.

"Agora a política é crescentemente controlar os fluxos de dados. Se muitos dados são controlados por uma pequena elite, veremos uma ditadura digital. É papel dos governos regular a propriedade dos dados. Não podemos deixar para as corporações. Elas não representam ninguém, e nenhum cidadão votou nelas", argumentou. Mas tal regulação, complementou, não pode ser apenas de um Estado individualmente, mas deve ser organizada como "um acordo global sobre vigilância e propriedade de dados".

Ameaças existenciais

Harari incluiu entre as tarefas do poder público uma última classe de riscos, relacionados ao que denominou "ameaças existenciais". Ele citou como exemplo destas a fabricação e o emprego de armas automáticas, também chamadas popularmente de "robôs assassinos". Assim como no item anterior, a proteção contra essas tecnologias perigosas não será eficaz em apenas um país, mas como um esforço global.

"Os robôs matadores são a tecnologia mais perigosa. Países podem dizer que não querem desenvolver, mas o fazem por não poder confiar nos rivais. Se permitirmos uma corrida assim, não importa quem ganha, perde a humanidade. Prevenir a corrida não é criar muros, mas construir confiança entre países", recomendou.

Outra ameaça existencial apontada pelo historiador é a própria mudança na ideia de evolução e seleção natural. Com o uso de bioengenharia e novas tecnologias como inteligência artificial, ele projetou possibilidades como a desconexão da consciência dos corpos por meio de suportes inorgânicos ou até mesmo da criação de entes inteligentes sem consciência.

"Seleção natural vai ser substituída por design inteligente. Vai ser a nova forma da evolução. Vai acender o reino do inorgânico. É possível que o planeta Terra seja dominado por entidades diferentes de nós, de como éramos dos chimpanzés. Em 200 anos, a Terra pode ser dominada por entidades superinteligentes sem consciência", anteviu.

Caminhos

Diante de cenários tão preocupantes, Harari terminou sua conferência lembrando que tais caminhos são possibilidades, não profecias. O emprego e a regulação das tecnologias dependeria de escolhas humanas. E, neste sentido, os governos teriam o papel chave, uma vez que são os entes democraticamente eleitos para conduzir os rumos da coletividade.

"A revolução IA coloca desafios sem precedentes. Se alguém tem medo de algum deles, ainda pode fazer alguma coisa em relação a isso. A coisa mais importante sobre tecnologia é entender que ela não é determinista. Podemos usar as soluções técnicas para criar diferentes formas de sociedades", concluiu o professor.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.