Se bot faz besteira, quem responde na Justiça? Como Brasil quer regular IA

Se uma inteligência artificial (IA) toma uma decisão errada, quem responde: a pessoa que decidiu usá-la ou o desenvolvedor dela? O questionamento parece coisa de ficção científica, mas o Brasil conta agora com um projeto de lei (PL 2338/2023) com princípios e regras para uso e aplicação da tecnologia.

Apresentado na semana passada, o texto foi fruto de um grupo de trabalho de juristas, especialistas e representantes da sociedade civil, que gerou uma minuta de projeto a pedido do Senado em dezembro de 2022, e que agora passa a transitar no processo legislativo.

Se resta dúvida, a empresa desenvolvedora da IA pode ser responsabilizada, caso ela não seja transparente sobre os riscos de determinada ação sugerida pelo sistema.

De forma resumida, ele define uma série de regras para empresas implementar e desenvolver sistemas de inteligência artificial - como fazer análise de riscos que podem ser causados pela tecnologia - e direitos das pessoas, como saber se está lidando com um sistema de IA e no caso de haver uma decisão automatizada, entender o que levou àquilo.

Por que é importante?

O uso de inteligência artificial não é necessariamente uma novidade - sistemas de email usam IA para filtrar mensagens de spam, por exemplo, há anos, e a recomendação de conteúdo do seu serviço de streaming favorito também use tipo de tecnologia para indicar filmes e séries.

A questão é que a IA tem sido usada também em áreas sensíveis, por exemplo:

- reconhecimento facial usado por forças de segurança pública: uma pessoa pode ser abordada na rua porque um sistema a confundiu com um procurado pela Justiça. Esse tipo de tecnologia já se mostrou discriminatório (principalmente contra pessoas negras) e ineficaz por diversos especialistas.

- análise de recurso de aposentadoria: um parente seu pode ter um recurso de aposentadoria negado por um sistema de IA; em março, uma análise do TCU (Tribunal de Contas da União) indicou que o INSS (Instituto Nacional do Seguro Social) usava uma inteligência artificial que tinha tendência de negar o direito à aposentadoria.

O que diz o projeto de lei?

A premissa da lei é criar normas para "desenvolvimento, implementação e uso responsável de sistemas de inteligência artificial no Brasil".

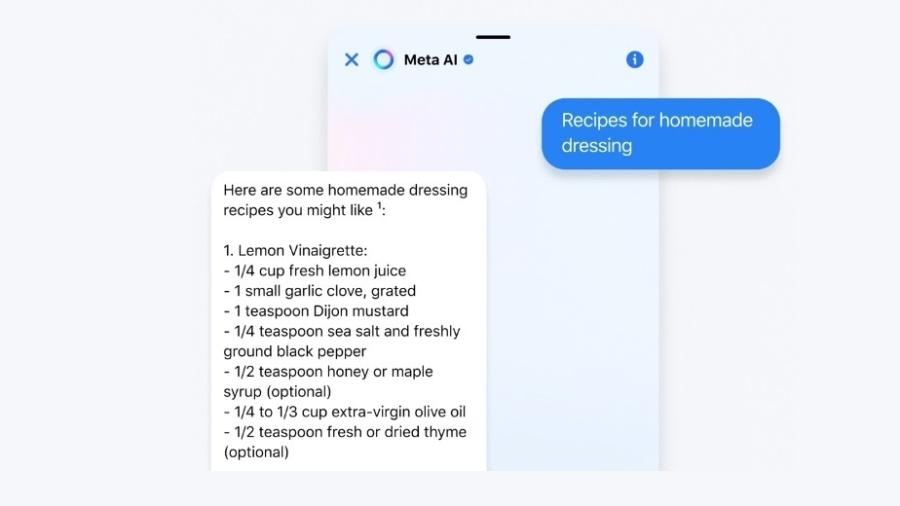

Transparência: "estou falando com uma IA?"

Inspirado no AI Act, legislação europeia ainda não promulgada sobre o tema, o projeto brasileiro é baseado no risco potencial das inteligências artificiais com a lógica de direitos das pessoas, segundo a Marina Garrote, pesquisadora na Associação Data Privacy Brasil de Pesquisa.

"A lei brasileira exige, por exemplo, que se você estiver falando com um chatbot [robô de conversa] de serviço de atendimento ao cliente, haja uma identificação clara que se trata de uma IA", explica.

O conceito de transparência se estende para várias áreas. Ainda que um chatbot de atendimento seja um uso sem grandes riscos, com a lei as pessoas deverão ter clareza sobre se as decisões que foram tomadas sobre elas foram baseadas em inteligência artificial, e quais critérios foram utilizados.

Direito: "Ué, por que esse sistema tomou essa decisão?"

Os sistemas de inteligência artificial deverão ter supervisão humana, e as pessoas têm direito à explicação, caso ache que uma decisão foi equivocada.

Para Luiz Philipe Oliviera, coordenador de Proteção de Dados e Inteligência Artificial da OAB-SP (Ordem dos Advogados do Brasil), isso é uma regra já presente na LGPD (Lei Geral de Proteção de Dados), mas que agora é complementado com o projeto de lei, que dita regras para o setor público.

"No tratamento governamental de IA, seguem servindo aos mesmos princípios de administração pública, como o da transparência, de que a pessoa sempre tem o direito de saber a razão de uma decisão", afirmou.

Punições e multas: avaliação conforme o grau de risco

Os sistemas de inteligência artificial serão classificados conforme o grau de risco, e as empresas devem fazer um estudo anterior para entender sobre as consequências do uso daquela tecnologia.

O projeto proíbe, por exemplo, o uso de IA em classificação e ranqueamento de pessoas baseada no comportamento social e em sistemas de identificação biométrica em atividades de segurança pública.

Sobre as atividades de alto risco, ele define, por exemplo:

- gestão e funcionamento de infraestruturas críticas, como trânsito e redes de abastecimento de água e de eletricidade

- sistema de educação e formação profissional

- avaliação para concessão ou revogação de serviços privados e públicos considerados essenciais

- avaliação de capacidade de endividamento das pessoas

- estabelecimento de prioridades para serviços de resposta a emergências

- veículos autônomos, quando uso puder gerar riscos

- investigação criminal

Em caso de algum problema com inteligência artificial, como a tomada de decisão de um sistema que afete muitas pessoas, a empresa ou o governo devem divulgar a infração, suspender o serviço (quando for conveniente) e até proibição de tratamento de bases de dados.

A multa simples pode ser de R$ 50 milhões por infração ou até 2% do faturamento.

Autoridade autônoma

O texto prevê a criação de uma autoridade autônoma que vai assegurar que as empresas cumpram a regulamentação.

O órgão também poderá reclassificar sistemas de inteligência artificial conforme o grau de risco, e ele quem vai aplicar multas a quem infringir as regras.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.