Rostos fakes parecem mais 'confiáveis' do que os reais; isso é preocupante

Não é novidade que as técnicas capazes de criar rostos falsos estão se aprimorando, dando origem a feições cada vez mais realísticas. Mas essas criações não são apenas similares a rostos humanos reais: em alguns casos, os traços falsos podem até parecer "mais confiáveis" do que os verdadeiros, segundo um novo estudo publicado na revista científica PNAS, da Academia Nacional de Ciências dos Estados Unidos.

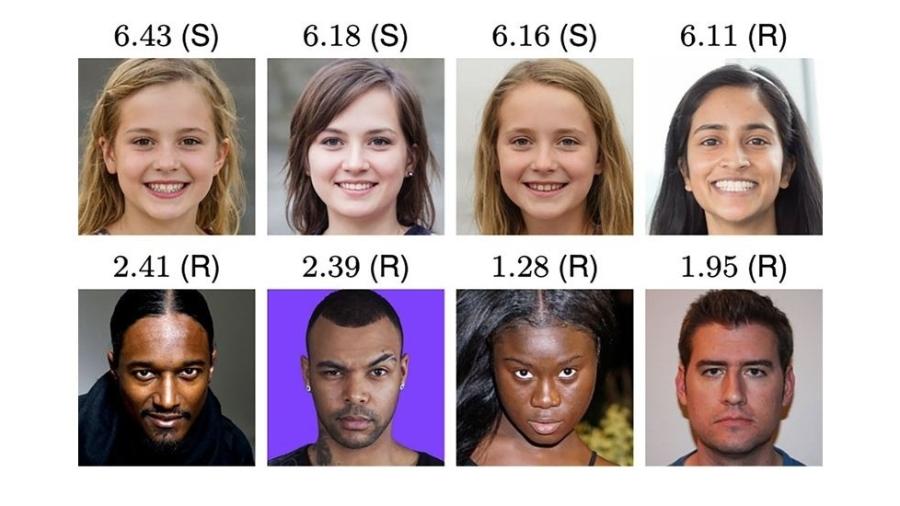

Foi o que os pesquisadores constaram após realizar vários experimentos para ver se rostos falsos criados por algoritmos eram capazes de confundir humanos. O resultado? Os rostos fake foram classificados como 8% mais confiáveis, em média, do que as fisionomias reais — levantando a preocupação de que eles possam ser "altamente eficazes quando usados para fins nefastos".

"Rostos gerados sinteticamente não são apenas altamente fotorrealistas, eles são quase indistinguíveis de rostos reais e são considerados mais confiáveis", observam os autores da pesquisa Hanry Farid, professor de ciências da computação da Universidade da Califórnia, nos Estados Unidos, e Sophie J. Nightingale, docente de psicologia da Universidade de Lancaster, no Reino Unido.

Como pesquisa aconteceu

A dupla de cientistas recrutou 315 participantes para distinguir uma seleção de 400 fotos falsas de um mesmo volume de imagens de pessoas reais. Cada conjunto era formado por cem indivíduos de diferentes grupos étnicos: brancos, negros, leste asiáticos e sul asiáticos.

Outro grupo, formado por 219 voluntários, recebeu treinamento sobre como identificar falsificações enquanto tentavam diferenciar os rostos. Seu desempenho, porém, não ficou muito acima da primeira equipe: 48,2% contra 59% de precisão média, respectivamente.

Já um terceiro grupo, de 223 participantes, precisou avaliar uma seleção de 128 imagens, atribuindo-lhes uma escala de confiabilidade de um (muito pouco confiável) a sete (muito confiável). A média atribuída aos rostos sintéticos (4,82) foi ligeiramente superior àquela das pessoas reais (4,48), uma diferença tida como "significativa".

E isso não foi à toa: segundo a pesquisa, a diferença provavelmente se deve ao fato de que rostos sintéticos se parecem mais com rostos humanos "médios", e as pessoas são mais propensas a confiar em "rostos típicos".

A responsável por trás dos rostos que não aparentam ter saído de máquinas é uma conhecida ferramenta de IA: a GAN (sigla em inglês para rede contraditória geradora). Ela funciona como um "vai-e-vem": enquanto um sistema é alimentado com um banco de fotos de pessoas reais para criar suas próprias imagens, outra parte do programa tenta detectar quais figuras são falsas.

O objetivo é que o produto final fique cada vez mais indistinguível da referência real. No estudo, o grupo usou o software StyleGAN, da empresa de tecnologia Nvidia. Trata-se de uma versão específica da ferramenta que mistura cores e estilos de diferentes traços, desde pose e formato da face até sobrancelhas e linhas de expressão, resultando em rostos de aparência natural.

"Não estamos dizendo que cada imagem gerada é indistinguível de um rosto real, mas um número significativo delas é", disse Nightingale à revista Scientific American.

Os resultados da pesquisa demonstram o avanço tecnológico das áreas de computação gráfica, mas o fácil acesso a essas imagens falsas de alta qualidade "levou e continuará a levar a vários problemas", alertam os pesquisadores.

Perigoso atalho para o mal

Um dos usos dessas ferramentas que mais despertam preocupação dos especialistas é a criação de vídeos pornográficos com o rosto de outras pessoas — a chamada "pornografia de vingança". Somente em 2020, mais de 100 mil mulheres foram vítimas de nudes falsos na internet, segundo relatório da empresa Sensity.

E esse não é o único perigo por trás do recurso. A tecnologia também pode ser usada para criar perfis falsos nas redes sociais com rostos aparentemente "confiáveis" e alimentar campanhas de desinformação, "com sérias implicações para indivíduos, sociedades e democracia", diz o estudo.

Entre as soluções para evitar ou mitigar essas consequências, os pesquisadores indicam a incorporação de marcas d'água robustas nas redes de síntese de imagem e vídeo pelos desenvolvedores. Mas não só isso.

Precisamos de diretrizes éticas mais rigorosas e mais marcos legais em vigor porque, inevitavelmente, haverá pessoas lá fora que querem usar [essas imagens] para fazer mal, e isso é preocupante". Sophie J. Nightingale, docente de psicologia da Universidade de Lancaster.

Não é uma tecnologia perfeita

Algoritmos de reconhecimento facial, como outros sistemas de IA, não são perfeitos. Por causa do viés nos dados usados para treiná-los, alguns desses sistemas não são tão bons, por exemplo, no reconhecimento de pessoas negras.

É por isso que, em 2015, um sistema de detecção de imagens desenvolvido pelo Google rotulou duas pessoas negras como "gorilas". É possível que o programa tenha sido alimentado com mais fotos desses animais do que de pessoas com a pele preta.

No estudo publicado no periódico PNAS, os pesquisadores também perceberam que rostos brancos eram os mais difíceis para as pessoas distinguirem entre reais e falsos. A hipótese é que o software utilizado foi desproporcionalmente treinado com rostos brancos.

Antes de investir nessas tecnologias, portanto, os especialistas consideram que os desenvolvedores devem considerar se os riscos associados são maiores do que os seus benefícios. "Se sim, desencorajamos o desenvolvimento da tecnologia simplesmente pelo fato de ser possível.

Caso contrário, incentivamos o desenvolvimento paralelo de salvaguardas disponíveis para ajudar a mitigar os possíveis danos".

*Com informações dos sites New Scientist, Scientific American e PNAS.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.