ChatGPT inventa lavagem de dinheiro e é alvo de 1ª ação na Justiça nos EUA

A OpenAI, empresa responsável pelo ChatGPT, a inteligência da moda, virou alvo de uma ação judicial por difamação nos Estados porque o chatbot inventou uma mentira sobre um radialista.

Primeira caso envolvendo a OpenAI por difamação que chega à Justiça, o processo é acompanhado de perto por especialistas em direito e tecnologia pois pode estabelecer parâmetros judiciais nos EUA sobre a responsabilidade das informações fornecidas pelo ChatGPT. A mentira vem sendo atribuída a uma "alucinação" da IA, termo que designa momentos em que o robô se comporta de maneira imprevisível e inexplicada.

Em resposta a um usuário, o robô acusou o radialista Mark Walters de ter desviado dinheiro de uma fundação, embora isso não tenha ocorrido na realidade.

Como se deu a acusação falsa

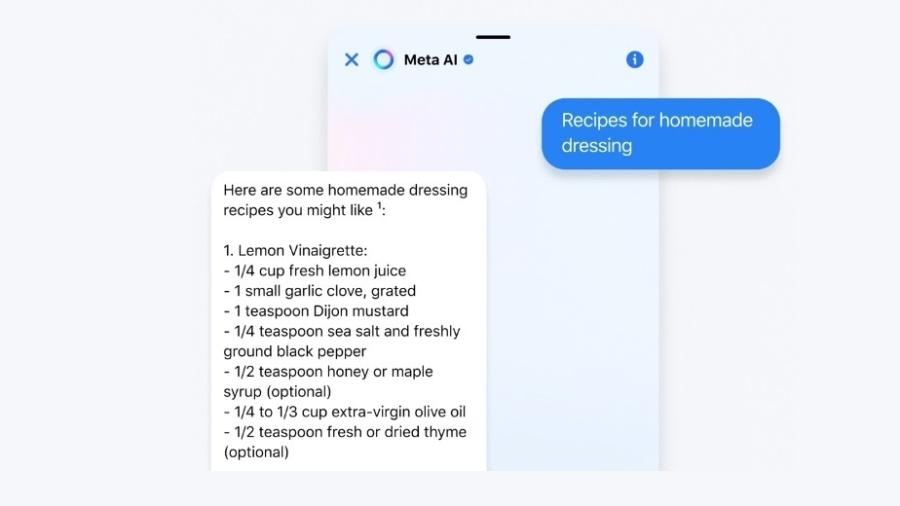

Segundo o site americano Gizmodo, o jornalista Fred Riehl soliciou ao ChatGPT, um resumo de uma disputa judicial envolvendo a Second Amendment Foundation (conhecida pela sigla SAF), uma organização pró-armas dos EUA.

O robô então disse que o pivô da contenda era o radialista Mark Walters, que seria acusado de desviar dinheiro da fundação. Nas palavras do chatbot, Walters teria se "apropriado indevidamente de fundos para despesas pessoais sem autorização ou reembolso, manipulado registros financeiros e extratos bancários para ocultar suas atividades e não forneceu relatórios financeiros precisos e oportunos".

Walters, porém, não tem qualquer relação com essa disputa -é difícil entender por que exatamente o chatbot o associou a ela. O radialista apresenta um programa pró-armas no estado norte-americano da Geórgia, mas não está ligado diretamente à fundação. O processo judicial citado pelo ChatGPT não menciona o nome dele nem tem a ver com desvio de dinheiro.

Como nada do que o ChatGPT escreveu era verdade, o radialista, ao saber que estava sendo falsamente acusado pelo robô, decidiu processar a OpenAI.

Por que o ChatGPT inventou essa história?

Não é a primeira vez que o robô de conversação da OpenAI fornece informações falsas de forma convincente. As chamadas "alucinações" ocorrem porque IAs como o ChatGPT são treinadas para prever qual a próxima palavra deve ser inserida numa sequência lógica de modo a replicar a forma como humanos escrevem.

Isso não quer dizer, porém, que elas tenham consciência do que estejam escrevendo, nem que diferenciem fatos de ficção. As alucinações são um grande desafio para empresas da área, não só por diminuírem a credibilidade das informações concedidas pelos chatbots, mas também por dificultar a compreensão de como os robôs chegaram a determinado raciocínio.

Sam Altman, fundador da OpenAI, já admitiu que as alucinações são um problema do ChatGPT. John Monroe, advogado de Walters, afirmou em entrevista ao Gizmodo que "é irresponsável" que a empresa libere para o público um sistema como ChatGPT, "sabendo que ele fabrica informações que podem causar danos".

A OpenAI pode ser condenada por difamação?

O ChatGPT foi aberto para uso público em novembro do ano passado. Desde então, episódios em que ele inventou informações sobre pessoas reais se acumulam. Um caso de destaque é o de Brian Hood, um político australiano que ameaçou processar a OpenAI após ser acusado pelo chatbot de envolvimento num escândalo de corrupção.

Segundo a IA, Hood teria sido condenado por tentar subornar diplomatas estrangeiros com dinheiro do banco central australiano. Mas era justamente o contrário: ele foi um dos delatores dos subornos. De certa forma, o ChatGPT transformou o herói de uma história em vilão.

O caso não foi para a frente. Hood, assim como Walters, é uma pessoa pública, com preocupações sobre a própria reputação. No entanto, especialistas judiciais ouvidos pelo Gizmodo se disseram céticos sobre as chances do radialista. Segundo eles, seria necessário que Walters demonstrasse de forma prática de que maneira sua reputação foi prejudicada pelas informações falsas do ChatGPT.

Eugene Volokh, professor de direito da Universidade da Califórnia, disse que, para vencer o processo, o radialista precisará também provar que a empresa "agiu com conhecimento de falsidade ou desconsideração imprudente da possibilidade de falsidade".

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.