Robô aprende sozinho a discriminar minorias na Coreia do Sul

Um assistente virtual tem provocado polêmica na Coreia do Sul. Criado a partir de algoritmos e conversas na internet, a ferramenta de inteligência virtual está sendo acusada de ter se comportado de forma discriminatória, proferindo mensagens ofensivas visando principalmente a comunidade LGBTQI+ e pessoas com deficiências.

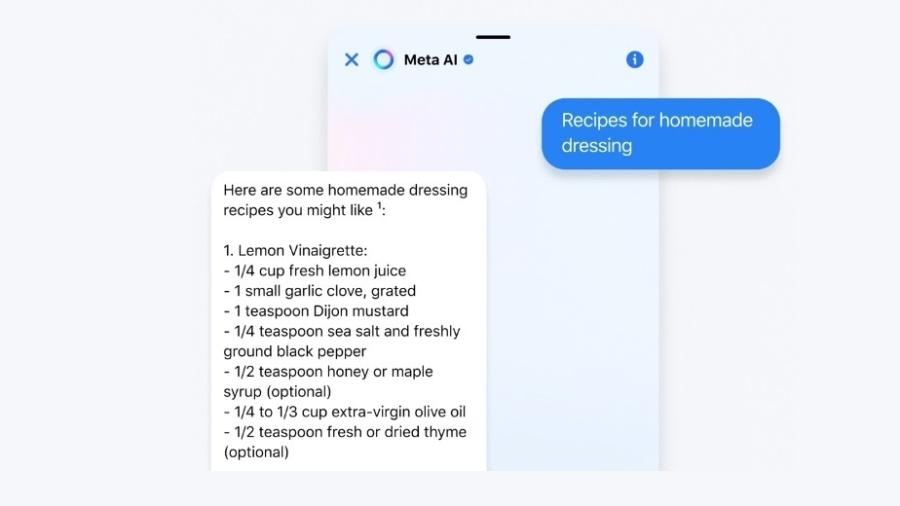

Batizado de Lee Luda, o "chatbot", uma espécie de robô virtual criado para conversar com seus usuários, foi concebido para se comportar como uma jovem de 20 anos. O objetivo do projeto, concebido pela empresa Scatter Lab, é acompanhar pessoas que se sentem sozinhas.

Para criar a ferramenta, os idealizadores se basearam nos dados do Science of Love, um aplicativo sul-coreano que já foi baixado por cerca de 100 mil pessoas. O dispositivo avalia o nível de afeição entre casais, gravando suas conversas. Em seguida, os internautas podem trocar mensagens com o algoritmo, que responde às perguntas via Messenger, uma prática comum na Coreia do Sul.

Apoiado no princípio do deep learning, que permite o desenvolvimento da inteligência artificial sem ajuda humana a partir de dados acumulados, o comportamento de Lee Luda foi construído a partir de uma compilação dessas conversas entre casais no Science of Love.

Mas o resultado é realista demais e mostra um lado nada politicamente correto da sociedade sul-coreana. Os usuários de Lee Luda, que esperavam conversar com um assistente virtual que os ajudaria a sair da solidão, foram surpreendidos por respostas de cunho explicitamente sexual ou claramente discriminatórios. Algumas mensagens diziam que as lésbicas eram "nojentas", que as mulheres eram agressivas por causa da menstruação ou ainda que os pessoas com deficiências deveriam se suicidar.

Proteção de dados pessoas nos aplicativos

Essa não é a primeira vez que um produto de inteligência artificial tem uma postura discriminatória. No entanto, nos casos registrados até agora o comportamento racista ou homofóbico havia sido ensinado pelos próprios usuários de forma consciente. Mas no caso de Lee Luda, a "atitude" do chatbot foi totalmente criada a partir de uma compilação de conversas, de forma independente.

O caso de Lee Luda levanta várias questões. Além de revelar uma forma de discriminação latente, ele chama a atenção para a utilização de dados pessoais dos aplicativos. Os usuários de Science of Love, não haviam dado de forma explícita o consentimento para que suas conversas alimentassem o que iria se tornar mais tarde o "cérebro" de Lee Luda. A aplicação havia informado apenas que os dados poderiam permitir o desenvolvimento de outros serviços, sem dar detalhes.

Com o escândalo de Lee Luda, os sul-coreanos se deram conta que todas as suas informações eram conservadas e exploradas de forma indevida. Criticada, a Scatter Lab interrompeu temporariamente seus serviços e autorizou os usuários de Science of Love a suprimir seus dados.

No entanto, a empresa se mantém otimista sobre o uso da inteligência artificial como uma ferramenta de convívio social. A direção da Scatter Lab afirma que, em cinco anos, serviços como Lee Luda se mostrarão eficazes para ajudar pessoas solitárias e isoladas a se sentirem melhor.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.