Texto em que o autor apresenta e defende suas ideias e opiniões, a partir da interpretação de fatos e dados.

Conheça a IA que já está na nossa vida para evitar que ela faça algo errado

Ainda que, para o público geral, o maior feito da Amazon tenha sido sua evolução de loja de livros para marketplace de quase tudo o que existe no mundo, para quem se interessa pela parte interna deste sucesso estrondoso, o que mais conta é a habilidade de ir criando divisões cujo principal objetivo é vender para o próprio grupo, como é o caso da AWS, uma das principais fontes de receita da Amazon, hoje em dia.

Neste espírito, a Amazon desenvolveu sua própria tecnologia de recrutamento e seleção (R&S), em 2014. A princípio, tudo parecia estar indo bem. A empresa estava investindo pesado em inteligência artificial e nada mais alinhado à sua metodologia do que usar este know-how para trazer gente cada vez mais qualificada.

Acontece que, já ano seguinte, começou a ficar claro que havia algo de errado com o novo sistema de R&S, fortemente enviesado.

A razão era óbvia: o algoritmo havia sido treinado com dados dos funcionários da empresa até aquele momento, os quais —surpresa— eram quase todos homens brancos. Assim, sua referência de "candidato(a) qualificado(a)" era exatamente esta.

A empresa se viu na necessidade de adotar rapidamente alguma medida de contenção de danos e focou a questão de gênero, eliminando das análises curriculares os campos "nome e "gênero" (Reuters foi fundamental neste processo, leia aqui). Não funcionou.

O viés seguia contaminando o sistema por diversas vias, por exemplo, pelo mapeamento dos descritivos alheios à carreira (p.ex., campeã da liga feminina de ciclismo amador) e as meras diferenças estilísticas que persistem, na maneira como as pessoas se apresentam.

Não restou à empresa outra alternativa senão o cancelamento do projeto, que se tornou um case na área de diversidade, vieses e tecnologia (para entender melhor, leia aqui).

Um pouco depois (2018), a empresa voltou a ser assunto, com o Rekognition, um software de reconhecimento facial que identificou incorretamente 28 congressistas americanos como criminosos encarcerados.

Mais de 40% dos falsos positivos recaíam sobre políticos negros; é fácil imaginar o estrago em situações em que os acusados são menos ilustres. Para conhecer mais sobre este case, acesse aqui.

É claro que não é só a plataforma da Amazon que apresenta estes erros.

Estudo do mesmo ano, de pesquisadores do MIT Media e Lab e Microsoft Research Lab, mostrou que três das mais populares plataformas de reconhecimento facial do mercado (Microsoft, IBM e Face++) têm desempenho muito inferior na identificação de negros do que brancos.

O problema é quase tão grave na comparação entre mulheres e homens.

Para os classificadores da Microsoft e IBM, a taxa de falsos positivos para mulheres é o dobro ou mais do que para homens. Já na Face++ (uma ferramenta chinesa líder de mercado), esta taxa é mais do que treze vezes maior."

(Buolamwini e Gebru, 2018; p. 10)

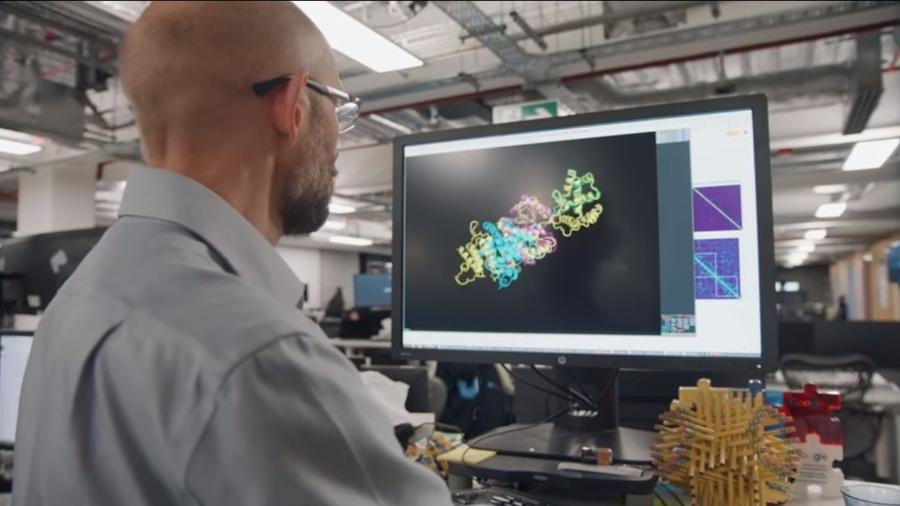

Já em 2019, a Science publicou um dos estudos de maior impacto da história no assunto.

Pesquisadores analisaram os registros de cerca de 20 milhões de pacientes do serviço de saúde americano e mostraram que os pacientes negros são considerados mais saudáveis (leia-se: menos doentes) do que seus pares brancos.

A consequência direta disto é a redução proporcional dos investimentos e tecnologias médicas no tratamento dos pacientes negros.

Em cada nível, medido pelo número de doenças crônicas, os negros geram custos $1801 menores por ano do que os brancos"

(Obermeyer, Powers, Vogeli e Mullainathan, 2019; p. 450)

Outro software que gerou case na área é o Compas, utilizado para apoiar juízes na determinação da magnitude das penas e progressão de regime, nos Estados Unidos.

Conforme as evidências mostram, o Compas tende a sobre-estimar, erroneamente, a chance de reencarceramento de presos negros mais de duas vezes mais do que de presos brancos. Vale ler este artigo aqui da coluna para entender melhor a discussão sobre o uso de algoritmos no sistema legal.

E assim a coisa segue, com dezenas de cases, nas mais variadas áreas.

Causas dos vieses da IA

Em geral, quando falamos em inteligência artificial queremos dizer algo bem mais específico. No caso, o tema em questão é o das plataformas de software que usam aprendizado de máquina para classificar padrões, fazer estimativas e tomar decisões.

O debate recorrente do tema levou-me à conclusão de que as maneiras existentes para classificar estes vieses podem melhorar. Assim, resolvi propor uma alternativa.

No meu ponto de vista, os vieses em inteligência artificial dão as caras de duas maneiras principais: como exclusão algorítmica mediada e como vieses líquidos do processamento.

Exclusão algorítmica mediada é aquilo que acontece quando a plataforma de software possui mecanismos que preveem ou permitem a discriminação direta de um grupo.

Por exemplo, qualquer um que quiser impulsionar seus posts do Instagram pode escolher o perfil etário e o local de residência daqueles que verão seu conteúdo. Isto na prática significa que a ferramenta prevê uma maneira do anunciante privar de acesso aqueles que julga menos interessantes para o seu posicionamento.

O Instagram não está sozinho nessa. Em geral, segmentação publicitária é uma área em que os recortes excludentes são previstos by design, dando vazão aos vieses dos anunciantes. Isto vale para notícias e todo tipo de "oportunidade".

Entre as consequências disto está o fato de que os melhores empregos corporativos tendem a aparecer mais para homens brancos do que para mulheres e negros, nas principais plataformas do mercado (acesse aqui para conhecer um case do Google e saber mais).

Vieses baseados na exclusão algorítmica mediada são de difícil eliminação, já que surgem da capacidade das big techs de se eximirem de responsabilidade, dado que o cliente é o agente final da discriminação.

Isto é diferente do que ocorre nas situações em que os vieses emergem automaticamente dos dados usados para o treinamento da inteligência artificial.

Vieses líquidos do processamento são justamente estes que surgem da incapacidade ou falta de disposição para tratar adequadamente os dados que configuram a inteligência artificial.

Um dos casos mais famosos e complexos é o do policiamento preditivo, que usa as ocorrências para determinar, automaticamente, como as forças policiais devem se distribuir.

Conforme exposto aqui na coluna, isto tende a levar a posturas (ainda) mais truculentas nas regiões mais vulneráveis do ponto socioeconômico e urbanístico, reforçando um problema que deveria estar sendo combatido.

Outro é o da concessão de crédito.

Não sei se você sabe, mas é comum que mulheres tenham limites de crédito inferiores a seus pares masculinos de mesma renda e idade (para um case da Apple, acesse aqui).

A última grande empresa a entrar na dança foi o Twitter, com seu sistema de edição de imagens, que parece "preferir" faces caucasianas.

Existem duas diferenças importantes entre os vieses que surgem do policiamento preditivo e os que surgem nas análises de crédito ou recorte de imagens.

A primeira é que, nestes últimos dois casos, o resultado do processamento algorítmico gera uma consequência direta sobre alguém, enquanto no caso do policiamento, esta consequência chega junto com as viaturas direcionadas pelo algoritmo.

Em outras palavras, no primeiro caso, o algoritmo é um agente decisório, enquanto no segundo ele serve de apoio à tomada de decisão.

Um algoritmo que avalia se o seu perfil é adequado para uma vaga é do primeiro tipo, ao passo que os algoritmos de recomendações de notícias, amizades e filmes são do segundo tipo.

Conforme falei recentemente, em palestra no Café Filosófico, estamos avançando para uma era de automação decisória, na qual os algoritmos não apenas apoiam as escolhas, mas efetivamente as realizam.

Os efeitos no cérebro desta passividade crescente já começam a ser sentidos.

A segunda diferença é mais sutil: a possibilidade de expurgar o algoritmo de seus vieses é mais difícil no contexto do policiamento preditivo. Isto porque está imbuído na distribuição das cidades em CEPs, os quais têm em si suas demografias bem definidas.

Ou seja, mesmo que todos os registros sobre cor, idade e gênero presentes nos boletins de ocorrência sejam omitidos, o mero fato de que existe uma forte relação entre raça e renda, em países desiguais como o Brasil e os Estados Unidos, faz com que a repressão policial incida de maneira mais intensa sobre a população negra.

É isto o que torna o algoritmo de policiamento preditivo "complexo" como eu disse acima.

O que fazer para melhorar?

As melhoras que conseguimos instituir de maneira mais simples podem ser divididas em transparentes e processuais, de acordo com a nomenclatura que criei para facilitar o debate.

Medidas transparentes são aquelas que todos enxergam. No caso da exclusão algorítmica mediada elas são mais claras e, por exemplo, envolvem a limitação nas variáveis de segmentação que podem ser usadas pelos contratantes de anúncios.

Tecnicamente, isto é conhecido como processo de criação de variáveis protegidas, as quais não podem ser manipuladas pelos usuários. Dispensável dizer que se trata de conhecimento padrão, francamente ignorado por parte do mercado.

Já as medidas processuais são bem mais complexas e tendem a funcionar melhor em combinação.

Primeiramente, precisam ser adotadas estratégias para reduzir os vieses nos dados que treinarão o novo sistema de inteligência artificial — as chamadas estratégias de pré-processamento.

Num segundo momento, algoritmos especialmente construídos para a detecção de vieses devem fazer o pente-fino da nova solução —são as chamadas estratégias de pós-processamento.

As duas principais instruções de pré-processamento que devem ser adotadas para "higienizar" os conjuntos de treinamento de sistemas de inteligência artificial são:

- Conferir se os dados que servirão para o treinamento do novo sistema de inteligência artificial são oriundos de fontes diversas, rejeitando-os caso não sejam.

- Conferir se contém campos para a identificação de raça e gênero. Estes campos não devem estar presentes nas situações em que isto pode introduzir vieses (quase todas).

No pós-processamento, a ação principal é testar se os resultados do modelo são enviesados.

Por exemplo, uma empresa que vai lançar um algoritmo para seleção profissional precisa testar se não tende a gerar diferenças de escore meramente em função do gênero, raça ou idade do candidato. Caso isto esteja acontecendo, é preciso barrar seu lançamento.

Uma estratégia que facilita a vida de quem está empenhado a eliminar vieses é usar algoritmos de detecção dos mesmos.

Aqui vai uma lista, que filtrei de recomendações da IBM/Trusted AI.

- Disparate Impact Remover (Feldman et al., 2015)

- Equalized Odds Postprocessing (Hardt et al., 2016)

- Prejudice Remover Regularizer (Kamishima et al., 2012)

- Calibrated Equalized Odds Postprocessing (Pleiss et al., 2017)

- Adversarial Debiasing (Zhang et al., 2018)

- Meta-Algorithm for Fair Classification (Celis et al.. 2018)

- Rich Subgroup Fairness (Kearns, Neel, Roth, Wu, 2018)

- Exponentiated Gradient Reduction (Agarwal et al., 2018)

- Grid Search Reduction (Agarwal et al., 2018, Agarwal et al., 2019)

Estas são as estratégias técnicas principais. Antes que você boceje de tédio, vou dizer que, de fato, o buraco é bem mais embaixo.

Primeiro, muitas vezes se coloca um trade-off entre precisão e higienização dos dados. Como disse Sam Colbert-Davies (Stanford) e colegas, em relação ao policiamento preditivo, "existe uma tensão inerente entre minimizar a ocorrência de crimes violentos e satisfazer as noções mais básicas de justiça".

Mitigar vieses depende da disposição para quebrar padrões deletérios.

Segundo, existe um problema sistemático de falta de diversidade entre os empresários que comercializam as ferramentas e os cientistas que as desenvolvem.

O debate sobre os vieses tende a ser distante de sua experiência, o que definitivamente não colabora.

Finalmente, existe um problema ainda maior, de apropriação. A população tem que ser suficientemente preparada para entender como estas tecnologias determinam seu dia a dia.

A lógica da inteligência artificial precisa ser matéria escolar corriqueira, para que formemos adultos capazes de reivindicar tratamentos éticos. Não basta aprender a fazer vídeo para o Instagram para fazer parte deste debate.

Para fechar

No artigo de hoje, apresentei uma maneira de pensar os vieses da inteligência artificial que eu acho mais precisa e enxuta do que as existentes. Seu resumo é o seguinte:

Os vieses da inteligência artificial que fazem parte das nossas vidas tendem a ser de dois tipos: exclusão algorítmica mediada e vieses líquidos do processamento.

O primeiro depende de um usuário para gerar seu impacto negativo, como no caso da segmentação propagandística, enquanto o segundo emerge da ideia de que o passado usado para treinar o sistema de inteligência artificial era enviesado, como no case dos currículos da Amazon.

Em paralelo, estes vieses podem se manifestar a partir dos outputs do algoritmo, como no caso da segmentação "inteligente" ou eles podem funcionar como sistemas de apoio decisório, como no caso do policiamento preventivo.

O que torna os algoritmos de exclusão mediada deletérios é a falha no mecanismo de geração de variáveis protegidas, isto é, dimensões que o usuário não pode selecionar. Por exemplo, segmentação por gênero, raça ou renda. Já os algoritmos que carregam vieses líquidos meramente traduzem a máxima: garbage in, garbage out.

Disto segue a necessidade de evitar treinar as inteligências artificiais com dados desbalanceados.

Dois passos básicos que devem ser dados nesta fase são: conferir se os dados vêm de fontes diversas e checar se possuem identificadores sociodemográficos que tendem a introduzir vieses.

Superado este ponto, é importante olhar para os resultados que o sistema entrega.

Nesta fase, o mais importante é se perguntar se algum grupo tende a ser prejudicado pela inovação. Bom senso ajuda, mas não resolve. Por isso, também é importante rodar algoritmos de detecção.

Estas medidas são capazes de reduzir a taxa de bizarrices, mas não conseguem chegar ao coração do problema, que é a combinação de falta de diversidade entre quem desenvolve e comercializa as soluções e falta de conhecimento geral da população sobre seu funcionamento.

Resolver isso é dar um passo grande para fora do subdesenvolvimento tecnológico. E assunto para um próximo artigo. Até lá.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.