Texto baseado no relato de acontecimentos, mas contextualizado a partir do conhecimento do jornalista sobre o tema; pode incluir interpretações do jornalista sobre os fatos.

Por que alguns tipos de IA são craques em previsão enquanto outros falham?

O futuro só a Deus pertence. Ou ao acaso, dependendo do seu ponto de vista. Mas isso não nos impede de tentar prevê-lo, obstinadamente.

De acordo com a CB Insights, consultoria de tendências que vende pacotes de relatórios, a partir de $60.000/ano, o momento recomenda manter um olho nos programas de incentivo baseados em blockchain, metaversos, tecnologias médicas portáteis e, claro, muita inteligência artificial.

O pessoal da consultoria Gartner, outra referência na área, popularizou um ciclo de desenvolvimento tecnológico que faz bastante sentido. De acordo com eles, tudo começa com um um salto técnico. Caso este seja suficientemente relevante e o esforço de divulgação seja adequado, o hype (representatividade na crista da onda, modismo) irá crescer rapidamente, atingindo alturas incompatíveis com o que a tecnologia de fato pode aportar.

A quebra de expectativas inaugura uma fase de descrença, na qual quem está mais preocupado com o hype do que com a coisa em si tende se voltar para a próxima novidade.

É enquanto as coisas esfriam no plano mais aparente, que os sentidos práticos vão sendo encontrados, pela capacidade da nova tecnologia de responder a demandas insatisfeitas.

Após encontrar estes espaços de legitimidade, a tecnologia se estabiliza e se torna parte do status quo, no qual entra na linha de tiro da concorrência, eventualmente perdendo a sua relevância.

Por trás desta ideia sobre a tecnologia e suas modas está a curva de difusão tecnológica, que Everett Rogers propôs para descrever a maneira como as posturas sobre a inovação se distribuem, no capitalismo de base ocidental.

Segundo ele, tudo começa num grupo pequeno (cerca de 2% da população), que de fato se aventura a fazer algo novo. Isto costuma dar origem a produtos ou serviços que os entusiastas (cerca de 13% da população) adotam, em nome da satisfação em consumir —e exibir— algo inovador.

Estas pessoas tendem a ter um traço da personalidade conhecido como abertura à experiência mais exacerbado e são justamente os produtores do furor que tanto assombra os menos consumistas.

Dali em diante, esfriamento e normalização dão as caras, enquanto a adoção se massifica (cerca de 68% da população, em sucessivas ondas).

Escritórios de inovação como a WeMind e outros vivem de separar o joio do trigo no momento em que o hype começa a acontecer, entendendo como a tecnologia funciona para criar em cima.

Já os laboratórios científicos focam mais o estalo inicial. Um exemplo brasileiro é o LinC (Laboratório Interdisciplinar de Neurociências Clínicas da Unifesp), onde vejo nascer coisas de tirar o chapéu.

A inteligência artificial se espalha por todas as fases da curva de Gartner. Seu hype multifacetário possui amplitude inigualável. Porém, se eu tivesse que inseri-la numa única caixinha, com certeza seria a dos sistemas preditivos.

Algoritmos de recomendação, que regem o funcionamento dos browsers e movimentam o dia a dia do marketing digital, servem para estimar preferências contextuais (que podem mudar de acordo com o que está em volta).

Escores de risco e crédito, que movimentam o dia a dia das operações financeiras e de seguros, servem para estimar as chances de cumprirmos contratos. Até os sistemas de segurança inteligentes partem de princípios semelhantes.

Há alguns dias, o general americano Glen VanHerck contou que o Pentágono está desenvolvendo um ecossistema que deverá prever eventos relevantes dias antes destes acontecerem.

De acordo com Glen, a ideia é espalhar sensores, câmeras, tomadas de satélite e outros dispositivos por vastas áreas para alimentar modelos preditivos, baseados em inteligência artificial.

A iniciativa recebeu o carinhoso apelido de GIDE, acrônimo que em português quer dizer: Experimentos para a Dominância Global de Informações. Fofo.

Estamos na era da futurologia - assunto que precisamos entender bem para não comprar gato por lebre, nem tampouco comer poeira. Isto inclui as estimativas de sucesso das novas tendências tecnológicas.

Inspirado pela ideia de dar escalabilidade àquilo que as consultorias de inovação fazem de maneira artesanal, Anuraag Singh, um ex-executivo do ramo automobilístico e pesquisador do MIT, concebeu o primeiro sistema de inteligência artificial que estima as chances de sucesso ou "evolução" das tecnologias emergentes.

A plataforma é open-source e cobre 1757 domínios tecnológicos distintos, por meio de registros de patentes. De acordo com o artigo científico que descreve a invenção, as áreas de crescimento mais forte na atualidade são:

- sistemas de troca de informação integrando múltiplos canais;

- aplicações de gestão de rede, focadas em clientes;

- sistemas de comunicação digital, incluindo propagandas.

Vale a pena entrar lá e testar coisas das áreas que você gosta para ver o que vem.

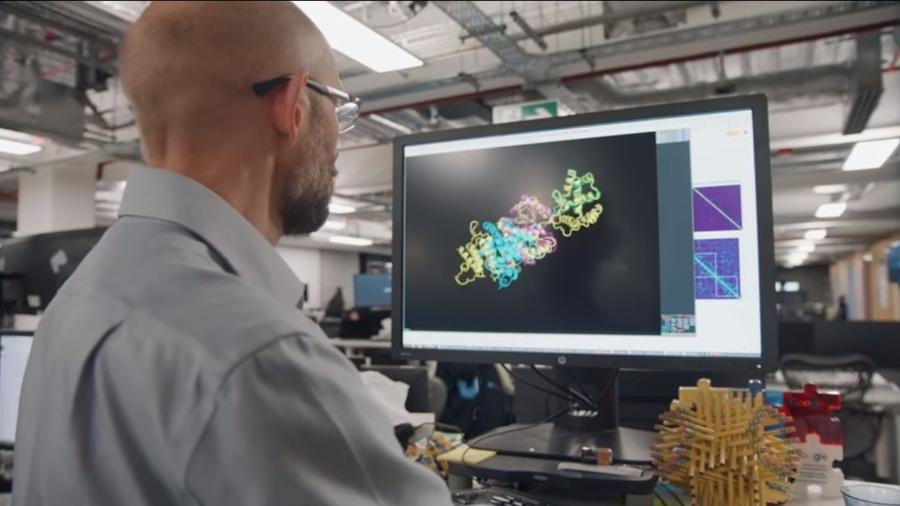

Na noite de 6 de agosto de 2021, fiquei brincando com isso. Uma das coisas que pesquisei é dobradura de proteínas (protein folding), que a plataforma indica estar evoluindo a cerca de 20% ao ano, pouco menos da metade da velocidade atual de desenvolvimento dos chips de computador.

Na minha opinião, bola fora da inteligência artificial de Anuraag, na identificação da maior conquista no campo da inteligência artificial até hoje, o Alpha Fold, solução criada pela DeepMind (Google) para estimar a estrutura tridimensional de proteínas, a partir de seus aminoácidos.

Tirando a água e a gordura, o nosso corpo é inteiramente constituído por estas macromoléculas. São cerca de 20.000 proteínas expressas pelo genoma, de um total de 100 milhões, distribuídas pelos seres vivos de todo o planeta.

A função exercida por cada proteína é intimamente atrelada à sua forma. Para que possamos criar maneiras de repará-las ou substituí-las, evoluindo no tratamento molecular de doenças, é preciso mapear a maneira como se dobram no espaço. Esta é uma tarefa que vinha sendo desenvolvida a passos lentos e muito esforço, por biólogos moleculares, ao redor do mundo.

Desde os anos 1990 existe uma divisão do Instituto de Saúde dos Estados Unidos (NIH) chamada de Avaliação Crítica de Técnicas de Predição de Estruturas Proteicas ou CASP, em inglês. Esse pessoal desenvolveu uma métrica para comparar os resultados de modelagens computacionais aos resultados obtidos pelas análises experimentais, as quais costumam usar uma técnica chamada cristalografia por raio-X para analisar as proteínas, ao custo de $20.000-120.000 cada.

A façanha do pessoal à frente do Alpha Fold foi atingir um nível de precisão semelhante ao obtido na bancada, por meio de um combo de algoritmos de modelagem preditiva e otimização.

O Alpha Fold não depende da análise direta das proteínas. O que ele faz é estimar a estrutura tridimensional da macromolécula, a partir da estrutura unidimensional dos aminoácidos que lhe constituem. É, portanto, mais um sistema preditivo, parente dos browsers e sistemas de crédito.

Há algumas semanas, a DeepMind tornou pública a representação espacial da totalidade de proteínas expressas pelo genoma humano, além de 330.000 outras. No embalo, liberou o código fonte do Alpha Fold para quem quiser se aventurar. Segundo artigo de divulgação da revista Nature, a medida soluciona um dos maiores desafios da história da biologia.

30 de agosto é o dia nacional de conscientização sobre a esclerose múltipla, doença que possui formas causadas por falhas na dobradura de proteínas (SOD1, TDP-43 e outras). É esperançoso pensar que avanços como este possam levar a terapias moleculares efetivas para a doença.

Menos esperançosa é a ideia de usar a inteligência artificial atual para antecipar os grandes saltos dados em seu próprio campo de desenvolvimento, conforme a gente nota pela incapacidade do sistema de Anuraag de mapear a ebulição algorítmica na biologia molecular.

Por que será que é assim? Por que quem de fato precisa saber o que está começando a ganhar embalo na curva de Gartner e de fato tem futuro, no contexto da inteligência artificial, depende da CB Insights e outros gurus?

A razão é dupla. De um lado, a gente ainda não entende o suficiente de inteligência artificial para dizer de fato o que é viável e o que não é.

A opção pelo uso da velocidade de evolução dos chips de computador que Anuraag Singh adota como benchmark para estimar o hype de uma tecnologia é decorrência do fato de que esses chips são o carro-chefe da Lei de Moore (1965), uma métrica de progresso tecnológico, que vem sendo acompanhada de perto há décadas.

Ainda não há uma Lei de Moore para a inteligência artificial. A coisa está mais para Harry Potter em começo de aventura, oscilando entre manifestações de poder e a franca infantilidade.

De outro lado, as inovações mais interessantes não seguem uma lógica aditiva. Pelo contrário, elas surgem pela negação do que está estabelecido, tomando emprestado métodos surgidos em contextos totalmente diversos.

A questão é que estes experimentos de risco costumam dar errado.

Cientistas geniais, bem equipados e com dinheiro tentam cinquenta vezes para acertar uma; cientistas mal equipados e sem dinheiro tentam cinquenta mil. Não dá para dizer de antemão qual será a bola da vez.

Tudo o que é possível é olhar a posteri e sentir que a de sucesso era candidata óbvia —uma falha de entendimento apelidada de viés retrospectivo.

Desde o começo da pandemia, mais de 400 soluções baseadas em inteligência artificial foram criadas para ajudar no diagnóstico da covid-19 e nenhuma obteve sucesso.

As razões incluem treinamentos insatisfatórios de algoritmos, erros nos diagnósticos médicos usados para os sistemas aprenderem e lançamentos sem fases de aperfeiçoamento (Beta).

Em paralelo, envolvem o fato de que tudo isso é muito novo e está sendo feito com base em suposições provisórias sobre a lógica da inteligência preditiva e do aprendizado.

A inteligência artificial não está sozinha no polo da incapacidade de prever as grandes conquistas humanas, mesmo quando vindas dela própria.

Como bem disse Venki Ramakrishnan, ganhador do Nobel de química de 2009 e presidente da Royal Society inglesa: a solução atingida pelo Alpha Fold para "este grande desafio da biologia de meio século, ocorreu décadas antes do que previsto no campo".

Eu gosto que seja assim. A gente erra bastante, mas no final, é muito mais divertido.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.