Disfarçar falta de conhecimento com IA ameaça o futuro da ciência

Não tem jeito. A ciência vai passar por revolução devido à IA. Está nas mãos dos próprios cientistas decidir se ela vai ser negativa ou positiva.

Os sistemas de IA generativa oferecem praticidade para uma série de atividades no nosso dia a dia. Podemos pedir para escrever um texto, criar um conteúdo ou então fazer uma pergunta sobre um tema que desconhecemos. Tudo isso é positivo desde que tenhamos um senso crítico no uso da ferramenta.

Nas últimas semanas, no entanto, tivemos muitas evidências de que este não parece ser o caso. Alguns cientistas estão usando IA para encurtar caminhos e acabam produzindo artigos de péssima qualidade, mas com um verniz científico, o que é ainda mais perigoso para o conhecimento humano.

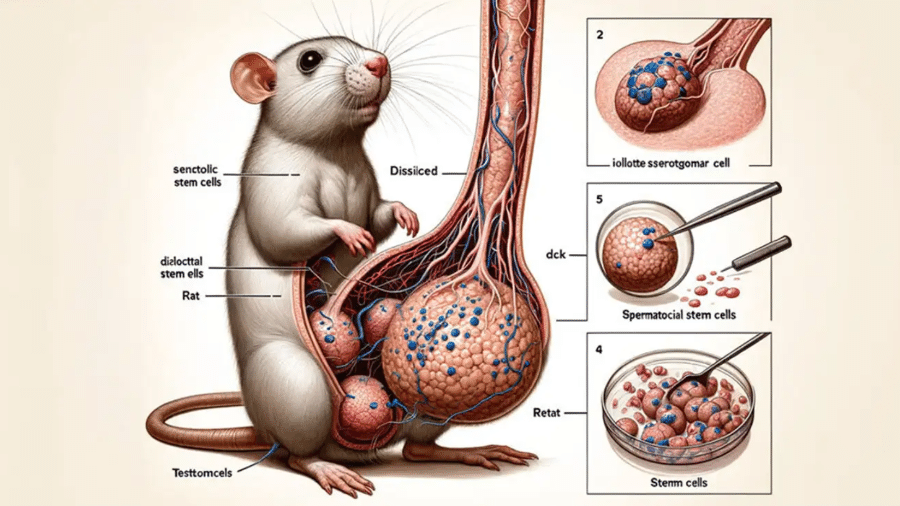

Entre os exemplos, está um artigo publicado na revista científica "Frontiers in Cell and Developmental Biology". Os autores do texto chegaram a criar nomes inexistentes para supostas células, como "Iollotte sserotgomar" e "testtomcels", e ainda produziram uma ilustração bizarra com IA de um rato com um testículo quase maior do que o seu corpo.

Também há dezenas de outros trabalhos que foram aceitos e publicados mesmo com frases fora de contexto criadas por IA. É o caso de um artigo publicado na revista "Surfaces and Interfaces", da Elsevier, que começa o primeiro parágrafo assim

Certamente, aqui está uma possível introdução para o seu tópico

Uma resposta típica do ChatGPT quando você faz algum pedido.

Mas a produção de artigos de maneira automatizada não é o único problema. Existe um outro, silencioso e ainda mais sensível: a confiança exagerada, sem senso crítico, em sistemas de IA.

Apesar de oferecer bons resultados, a IA está longe de ter uma habilidade sobrehumana a qual podemos confiar sem questionar seus resultados. O desafio é que uma parcela da comunidade científica, especialmente aquela que não está trabalhando diretamente com a temática de IA, muitas vezes não entende todas essas limitações.

Em um artigo publicado recentemente na "Nature", pesquisadores argumentam que as soluções de IA podem explorar as nossas limitações cognitivas e criar uma "falsa ilusão de entendimento", nos fazendo sentir que entendemos algo melhor do que realmente acontece.

Os autores analisaram mais de 100 artigos para elaborar um panorama das maneiras como os cientistas veem os sistemas de IA. A partir disso, chegaram a 4 visões distintas que a comunidade científica tem sobre IA:

- Oráculo: uma entidade capaz de ler incansavelmente e em uma velocidade absurda os artigo científicos, examinando a literatura científica de uma maneira mais abrangente do que os humanos.

- Árbitro: uma avaliadora de descobertas científicas de uma forma mais objetiva, que não tem propensão para selecionar uma literatura que suporte uma ideia.

- Quantitativo: uma ferramenta que ultrapassa os limites da mente humana em uma análise complexa de um vasto conjunto de dados.

- Substituto: as ferramentas de IA têm potencial para simular dados que são muito difíceis ou complexos de obter.

Ao ler cada uma dessas visões, eu consigo enxergar o potencial de cada uma delas para melhorar a ciência. E elas podem, de fato, ser importantes. Só que os autores argumentam que é exatamente a partir delas que muitos riscos surgem se tivermos um entendimento limitado do funcionamento da tecnologia.

Entre vários riscos relatados no artigo, eu destaco a "ilusão da amplitude exploratória", uma ilusão de compreensão. Ocorre quando os cientistas acreditam falsamente que estão explorando todo o universo possível de hipóteses testáveis, mas, na verdade, estão explorando apenas um espaço restrito das ferramentas de IA.

Esse é um risco sensível especialmente quando se usa IA para estudar sobre a subjetividade e o comportamento humano. Hoje, está começando a ficar na moda usar a tecnologia para investigar o comportamento a partir de simulações que podem ser feitas a partir de agentes inteligentes.

Newsletter

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Quero receberO problema é que ainda não é possível capturar toda a existência humana - e talvez nunca seja -, mas muitos pesquisadores não se atentam a essas limitações.

Durante anos, eu trabalhei com pesquisas em Computação Afetiva, área que junta IA e ciência cognitiva para estudar a viabilidade da tecnologia em reconhecer e representar as emoções humanas. Uma das aplicações mais comuns do campo é a detecção das emoções por meio das expressões faciais.

Parece até mágica: a IA circula o rosto de uma pessoa em um vídeo e diz que ela está 70% alegre, 20% apreensiva e 10% satisfeita.

A interface dá uma certeza que fica difícil de alguém questionar, afinal ela processou centenas de milhares de imagens de expressões faciais pareadas com a descrição de uma emoção para aprender a fazer essas correlações.

Só que hoje, as evidências científicas mostram que é muito difícil fazer o mapeamento de uma expressão facial para um estado mental, como uma emoção.

Aquele lance de emoções básicas e universais está em xeque.

Em 2022, eu organizei um painel para discutir esse tema durante o Fórum de Governança da Internet da ONU, com a participação da neurocientista Lisa Feldman Barrett, uma das maiores especialistas nos estudos das emoções humanas, a Microsoft e representantes da sociedade civil.

No fim do painel, o consenso estava estabelecido: é imprudente usar IA para inferir sobre a subjetividade humana. Naquele mesmo ano, a Microsoft, que tinha um dos principais modelos de reconhecimento de emoções por expressões faciais, aposentou seu sistema alegando falta de evidência científica.

Se você chegou até aqui, pode estar pensando: "que texto negativo". É melhor a ciência abandonar o uso da IA.

A ideia não é essa. Eu super acredito que a IA pode trazer muitos benefícios para o avanço da ciência e novas descobertas. O caso do AlphaFold, que revoluciona as pesquisas sobre proteínas, é um exemplo.

O que precisamos é alertar a comunidade científica para um uso crítico das ferramentas e que possamos até mesmo repensar o fazer científico. O modelo de ciência hoje, em que tudo é avaliado pela quantidade de publicações, fortalece a tendência de uso da IA numa espécie de processo de terceirização. Outro modelo é possível?

Recentemente, o Matheus Petroni, meu aluno de mestrado, defendeu a sua dissertação sobre as possíveis consequências da IA na ciência. Usamos a abordagem de design especulativo para investigar os cenários futuros de uso de IA no fazer científico. Após entrevistas e workshops, dois cenários foram criados para os próximos 10 anos:

- cenário provável: a ausência de letramento e uso crítico da IA leva a uma produção insana de novos artigos, mas a maioria quase que um pastiche dos trabalhos existentes e sem grandes contribuições para o avanço do conhecimento.

- cenário desejável: com um forte letramento e uso crítico, os pesquisadores entendem as potencialidade e limitações da máquina e passam a usá-la apenas para tarefas específicas, sem ser como uma terceirização do seu trabalho.

Alinha com este nosso cenário desejável, o artigo publicado na Nature defende que os cientistas olhem para aquelas visões para evitar cair em armadilhas quando planejam usar IA em suas pesquisas. Também argumentam que os cientistas devem usar a tecnologia apenas em áreas que já têm expertise, para não cair no risco de ser engabelado pela máquina.

De fato, a gente precisa sempre lembrar a sociedade de que a Inteligência Artificial não substitui a falta de conhecimento.

Deixe seu comentário