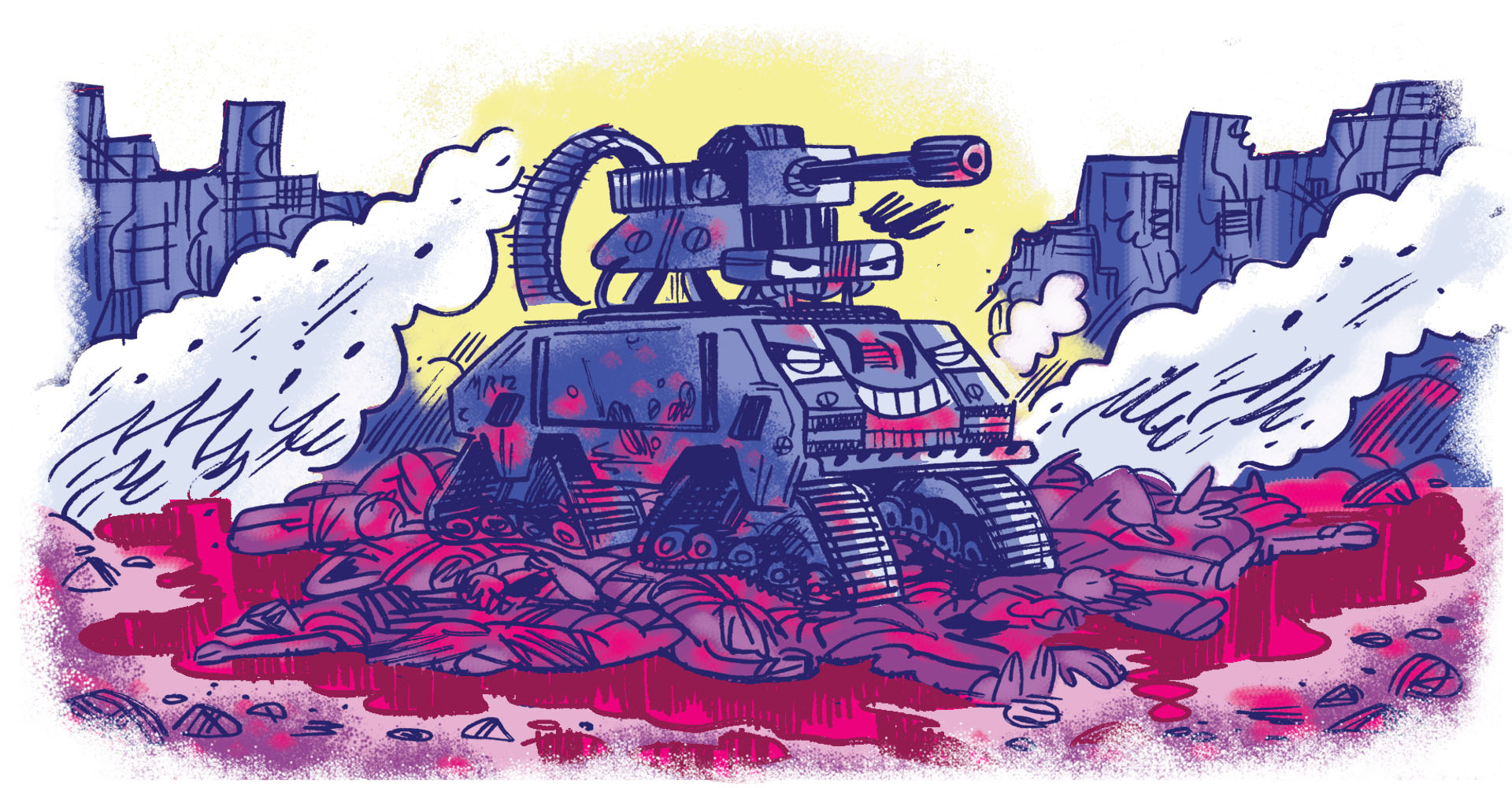

Um drone programado para reconhecer certos perfis e atirar. Uma máquina controlada remotamente que luta guerras a milhares de quilômetros de distância. Um ataque hacker que acaba com a luz de hospitais e derruba a energia de uma base militar, e a resposta a isso é feita com armas nucleares. Soldados equipados com óculos de realidade virtual que detectam o inimigo.

Até ontem tudo isso era só ficção, mas já chegamos nesse ponto dos avanços bélicos. Estamos falando de uma série de novos recursos tecnológicos cujos usos ainda serão experimentados e em contextos onde ainda não há regras específicas —o que dificulta, por exemplo, que países saibam o que é um ataque (e o que merece retaliação).

Os fóruns onde essas novas armas deveriam ser discutidas são estruturalmente incapazes de lidar com a "evolução exponencial" das aplicações militares. E, enquanto soluções não surgem, o cenário é de caos.

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.

Um boletim com as novidades e lançamentos da semana e um papo sobre novas tecnologias. Toda sexta.