'Reconhecimento facial para fim policial nasce já como derrota humanitária'

A tecnologia não é neutra, e inúmeros exemplos provam que ela reproduz os comportamentos discriminatórios da sociedade de diversas formas. O racismo, por exemplo, está presente em filtros "embelezadores" que deixam a pele mais clara por considerar que esse é o padrão de belo. E plataformas de armazenamento de imagens já categorizaram fotos de pessoas negras como gorilas.

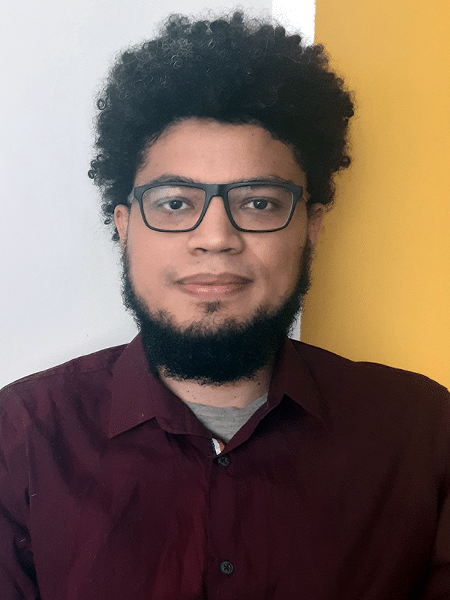

A discriminação feita por máquinas, suas consequências e formas de mitigar o problema são os assuntos abordados no livro publicado há poucas semanas "Racismo Algorítmico: Inteligência Artificial e Redes Digitais" (Edições Sesc, 2022), escrito pelo pesquisador Tarcízio Silva, que estuda o tema há seis anos.

Doutorando em ciências humanas e sociais na UFABC (Universidade Federal do ABC) e pesquisador da Fundação Mozilla, ele mantém em seu site uma linha do tempo do racismo algorítmico, reunindo vários casos e repercussões sobre o tema. Lá, é possível ver como o fenômeno atinge não só negros.

Tem o exemplo de quando o iPhone X não distinguia pessoas chinesas (telefone desbloqueava tanto com filho quanto com a mãe) e o de uma startup que dizia identificar traços faciais de terroristas, como se fosse possível identificar criminosos só pela aparência.

Em entrevista a Tilt, Silva diz que o problema das tecnologias algorítmicas é que elas reproduzem a discriminação em escala e de modo a "não permitir fácil avaliação ou auditoria de seus impactos".

Tecnologias digitais emergentes como reconhecimento facial para fins policiais ou criação de escore de risco para planos privados de saúde nascem já como derrotas humanitárias pesquisador Tarcízio Silva

Confira a seguir a entrevista completa. Como trata-se de um tema que envolve aspectos técnicos, algumas respostas foram editadas para dar mais clareza.

Tilt: Como você define o racismo algorítmico para quem não conhece o tema?

Tarcízio Silva: Racismo algorítmico descreve como as tecnologias digitais, em um mundo desigual construído pela escravidão e violência, podem promover ainda mais desigualdade através da extração acelerada de valor entre grupos, com minorias raciais em desvantagem.

Tal extração de valor não se trata só de valor financeiro e trabalho, mas também de valores comunicacionais, estéticos ou políticos como vemos no discurso de ódio, discrepância de visibilidades nas mídias ou falhas em reconhecimento facial.

No caso de tecnologias algorítmicas, as decisões dos detentores das tecnologias digitais são reproduzidas em escala e com opacidade — ou seja, sem permitir fácil avaliação ou auditoria de seus impactos.

Tilt: De que formas o racismo algorítmico mais se manifesta no dia a dia das pessoas?

Silva: As tecnologias digitais possuem dualidades que podem pender para a opressão em sociedades marcadas pelas desigualdades.

Manifestações mais individualizadas do racismo algorítmico podem acontecer, portanto, em quase todas as esferas da vida que são cada vez mais mediadas por tecnologias digitais como plataformas, aplicativos e sistemas de classificação e ranqueamento.

Tilt: Em seu livro, você explica que algumas tecnologias são racializadas, como a fotografia. Você poderia explicar por que a origem de algo, que hoje é tão banal por causa dos celulares, tem um componente racista?

Silva: No livro citamos algumas pesquisas que mostram como a calibração de processos de revelação fotográfica era orientada por um fabricante com exemplos de beleza de uma modelo branca americana. Como os instrumentos eram calibrados com uma referência única de beleza e distribuição de elementos visuais, as práticas penalizavam pessoas não-brancas.

Na era das selfies e mídias sociais como o Instagram, a prática se reproduz de forma similar em aplicativos de filtros, de "embelezamento" ou outros app lúdicos que usam visão computacional e realidade aumentada. O histórico de aplicativos que geram branqueamento ou resultados aberrantes em rostos negros é um eco dos problemas da universalização violenta de valores estéticos, que ganha ainda mais escala e velocidade nos meios digitais.

Tilt: Por que existe ainda a percepção de que as tecnologias discriminatórias são parte de um problema atual, quando isso é bem antigo?

Silva: Sim, o epistemicídio [apagamento de conhecimentos não ocidentais] é uma constante na história da opressão racial. Negar a existência do racismo e seus impactos é um pilar do racismo estrutural, ao tentar assim impedir a autodefesa dos grupos minoritários.

O livro é uma tentativa de colaborar com as iniciativas que buscam desvelar a ideia de neutralidade na tecnologia, trazendo ao foco o diálogo com colaborações de intelectuais brasileiros como Abdias Nascimento e Sueli Carneiro.

Tilt: Só existe racismo algorítmico porque ele é reflexo de contexto e de dados anteriores. Como é possível reverter isso?

Silva: Eu diria que manifestações do racismo algorítmico podem acontecer devido à implementação veloz e socialmente irresponsável de mecanismos de aprendizado de máquina, mas também a própria implementação de certas tecnologias quer fortalecem as opressões de raça, classe e gênero.

Sistemas de escore de crédito, por exemplo, por priorizarem uma ideia de risco que favorece de forma desproporcional o setor financeiro, submetem os consumidores às suas regras.

Em um país desigual como o Brasil, seria necessário o contrário pelo bem-estar social: políticas afirmativas para pessoas pobres e minorias acessarem recursos e movimentarem a economia. Como, então, desigualdades são mantidas também pela inação ou pela manutenção de relações de desigualdades, para de fato reverter o racismo algorítmico precisamos repensar a própria existência de algumas práticas de processamento de dados.

Tilt: É comum o uso de reconhecimento facial em segurança pública. Você acha que este tipo de tecnologia está madura o suficiente?

Silva: Entender sistemas algorítmicos não envolve apenas o caminho de analisar as linhas de código, mas também suas redes de delegação; envolve identificar quais comportamentos normalizam, quais dados aceitam, quais tipos de erro são ou não considerados entre entradas e saídas do sistema, seu potencial de transparência ou de opacidade e para quais presenças ou ausências os sistemas são implementados.

No caso do reconhecimento facial no espaço público, não há lugar para o recurso em sociedades democráticas, antidiscriminatórias e livres. Se queremos um futuro, tecnologias biométricas no espaço público não podem estar no nosso rol de respostas para problemas sociais que mais têm a ver com a desigualdade econômica, violência estatal ou ideologias arcaicas, como a criminalização de substâncias como a cannabis.

A tecnologia de reconhecimento facial hoje é altamente imprecisa para encontrar pessoas específicas, mas, se fosse completamente precisa, teria impactos nocivos de outra ordem como a promoção do encarceramento em massa ou constrangimento da liberdade de movimentação e privacidade de dados de todos os cidadãos.

Em termos de bem-estar social, reconhecimento facial para vigilância em massa nunca será uma tecnologia madura.

Tilt: O que as pessoas podem fazer para lutar contra o racismo algorítmico na segurança pública?

Silva: Cidadãos podem pressionar diferentes setores com poder decisório e político. A "Carta aberta para banimento global de usos de reconhecimento facial", organizada e assinada por centenas de organizações e pesquisadores em torno do mundo, apresenta solicitações que ganham tração global.

Por exemplo:

- exigir de legisladores e gestores públicos que proíbam o uso dessas tecnologias para vigilância de espaços públicos e acessíveis ao público;

- pedir a entidades privadas cessar a criação, desenvolvimento, venda e uso de reconhecimento facial e outras tecnologias de reconhecimento biométrico remoto que permitem a vigilância em massa e discriminatória direcionada;

- ou ainda que trabalhadores de empresas de tecnologia, com o apoio de seus sindicatos, se organizem em seus locais de trabalho contra o desenvolvimento ou venda de reconhecimento facial.

Tilt: Considerando que é uma questão estrutural, como você tem visto as formas de reduzir ou eliminar vieses discriminatórios. Tem bons exemplos atuais que você pode citar?

Silva: Especificamente para a redução ou eliminação de vieses, há iniciativas em campos da comunicação, direito e computação que buscam remediar os problemas através de ações como promoção da diversidade na programação, auditorias públicas dos problemas e/ou promoção de iniciativas alternativas [Exemplos práticos são:]

- Bancos de imagens diversos como o Nappy ou ygb.black;

- Projetos de formação [profissional] como AfroPython e Perifacode;

- Projetos contra vieses na IA como o World White Web ou Common Voice;

- Repositórios profissionais como o Afrosaúde permitem que minorias se defendam ao mesmo tempo que colaboram para toda a sociedade.

Mas é importante observar que a recusa em aceitar certas tecnologias pode e deve estar em nosso rol de iniciativas também.

Se efetivamente nos compromissarmos com princípios do valor da vida humana, chegaremos à conclusão de que algumas tecnologias algorítmicas não deveriam sequer existir. Campanhas internacionais que pedem o banimento do reconhecimento facial ou projetos de lei com este fim merecem atenção.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.