Microsoft cria IA que quer prever quais adolescentes vão engravidar

Em 2018, o Ministério da Primeira Infância da província de Salta, na Argentina, e a gigante da tecnologia americana, Microsoft, apresentaram um algoritmo capaz de prever quais futuras adolescentes provavelmente ficariam grávidas.

A região é fortemente associada com movimentos conservadores, e apesar de o aborto ser sancionado no país no início de 2021, o estigma e a lentidão na implementação de políticas públicas faz com que muitas mulheres ainda precisem recorrer a métodos clandestinos. Por conta disso, o algoritmo se tornou alvo de polêmica.

O que rolou

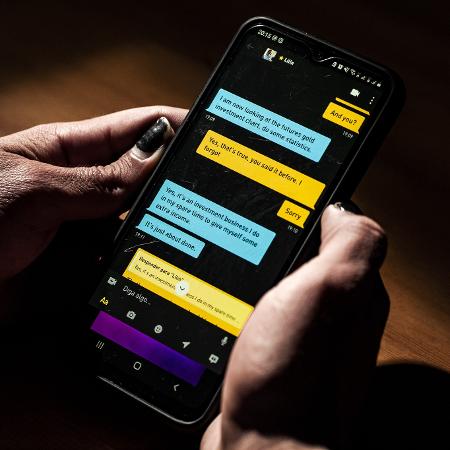

Chamado de "Plataforma Tecnológica para Intervenção Social", o algoritmo foi criado para trabalhar a partir de dados demográficos que incluem idade, etnia, deficiência, país de origem e até mesmo se a casa tem ou não água quente no banheiro.

De acordo com reportagem do site Wired, foram enviados "agentes territoriais" para visitarem as casas das meninas e mulheres em questão. Perguntas, fotos e registros locais de GPS foram feitos para a pesquisa.

No entanto, todas as pessoas em análise tinham algo em comum: eram de classes sociais mais baixas, algumas migrantes da Bolívia e de outros países da América do Sul e outras eram de comunidades indígenas Wichí, Qulla e Guarani.

Na mesma época em que Juan Manuel Urtubey, governador da província de Salta, declarava em rede nacional que a tecnologia podia prever com até seis anos de antecedência se a menina está 86% predestinada a ter uma gravidez na adolescência, o Congresso da Argentina debatia se deveria descriminalizar o aborto.

A tecnologia merece destaque não por ser "um dos casos pioneiros no uso de dados de IA", como anunciaram os porta-vozes da Microsoft, mas pelo programa ter sido implantado em um país com um longo histórico de controle de população por meio da vigilância e da força.

O Laboratório de Inteligência Artificial Aplicada da Universidade de Buenos Aires alegou graves erros técnicos e de design na plataforma, segundo a reportagem da Wired, além de destacar que o banco de dados do sistema incluía dados étnicos e socioeconômicos, mas nada sobre acesso à educação sexual ou contracepção — duas das ferramentas mais importantes na redução das taxas de gravidez na adolescência.

Assim como a maioria dos sistemas de IA, falta transparência e responsabilidade na Plataforma Tecnológica para Intervenção Social, uma vez que o programa nunca foi submetido a uma revisão formal. Além disso, nenhuma avaliação de seus impactos sobre meninas e mulheres foi feita. Tampouco houve publicação de dados oficiais sobre sua precisão ou resultados.

O programa foi criticado publicamente por acadêmicos e jornalistas, enquanto ativistas feministas usaram essa atenção para impor uma medida de responsabilidade pública.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.