Interesse por algoritmo ético bombou no Twitter, mas falta mudança prática

Nem só de memes, xingamentos e embates sobre política vive a nossa linha do tempo do Twitter. Uma pesquisa divulgada pela empresa com exclusividade a Tilt mostra que tem muita gente interessada em levar conversas sobre IA (inteligência artificial), implicações éticas da tecnologia e potenciais aplicações para o debate virtual.

Segundo o levantamento, chamado de Twitter Trends Brasil, falar de inteligência artificial ganhou uma relevância exponencial na rede social, principalmente nos últimos dois anos. Houve um crescimento de quase 400% em menções sobre o tema.

Além disso, conversas sobre as implicações éticas da tecnologia e o uso de dados tiveram um aumento de mais de 150% no período.

A pesquisa foi realizada pelo Twitter, em parceria com Black Swan Data e Crowd DNA, e teve como objetivo observar as principais tendências culturais dos últimos dois anos na plataforma no Brasil. Para isso, foram analisados bilhões de postagens, organizadas em mais de 300 mil tópicos de conversas durante o período, informou a empresa.

A pesquisa aponta ainda que conversas sobre como a tecnologia pode servir a propósitos maiores e melhorar a sociedade por meio da inovação cresceram 20% no Twitter. Além disso, as conversas sobre o uso da tecnologia na saúde aumentaram quase 150% no período.

De acordo com o Twitter, a conectividade e a integração entre ser humano e tecnologia, assuntos que passaram a ser ainda mais relevantes durante a pandemia de covid-19, também foram destaques. Houve crescimento de 41% em publicações sobre tecnologia e uma alta de 241% em conversas sobre tecnologias mais novas, como o 5G.

Algoritmos racistas na mesa de debate

Os debates sobre ética e inteligência artificial têm ganhado mais espaço como provam os dados acima. Mas um dos motivos para o crescimento das discussões pode estar ligado ao crescimento de estudos científicos e compartilhamento de provas que mostram como tecnologias possuem comportamentos racistas e machistas.

O próprio Twitter reconheceu publicamente que o algoritmo da rede social recortava imagens postadas na rede social privilegiando o rosto de pessoas brancas. A falha no algoritmo foi detectada em outubro do ano passado, quando internautas mostraram que esse corte automático de imagens discriminava rostos de pessoas negras. O assunto gerou vários comentários críticos sobre a plataforma.

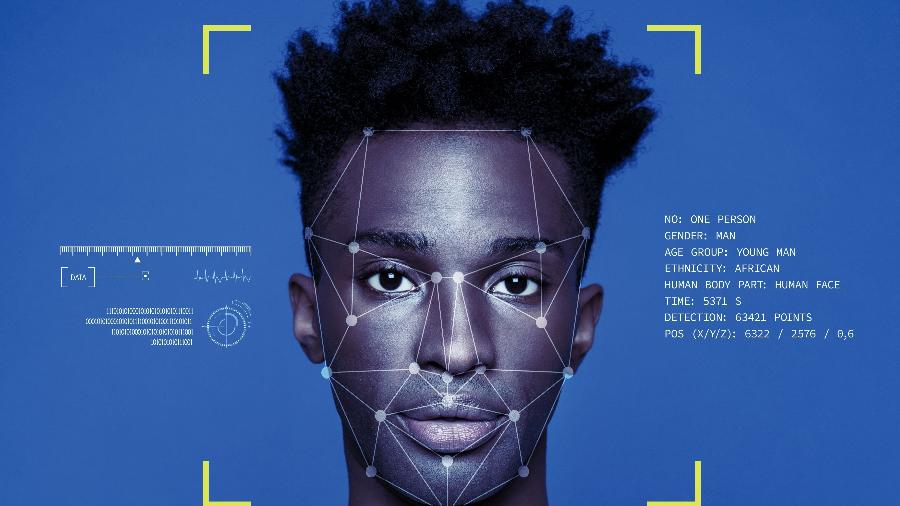

Com a repercussão, o Twitter decidiu investigar para comprovar se seu algoritmo era mesmo racista ou não. O teste consistia em fazer o sistema reconhecer rostos de pessoas brancas e negras em um banco de imagens aleatório criado para o experimento, com fotografias de indivíduos brancos e pretos, homens e mulheres.

Em post divulgado no seu blog oficial, a diretora de engenharia de software da empresa, Rumman Chowdhury, reconheceu o erro ao compartilhar os resultados do experimento.

Segundo a empresa, as respostas obtidas com a análise serviram para desenvolver melhorias no sistema de destaques em imagens do Twitter, que já começaram a ser implementadas progressivamente nos sistemas Android e IOS desde o início de maio.

Não é só no Twitter

O problema de tecnologias que discriminam não está isolado à inteligência artificial do Twitter. Algoritmos de reconhecimento facial já foram responsáveis pela prisão de jovens negros inocentes, confundidos pela IA com criminosos.

Nos EUA, um rapaz negro de 26 anos foi preso após uma falha no software de reconhecimento facial da polícia de Detroit, em setembro do ano passado. Meses antes, em junho, o mesmo software já havia errado, o que levou à prisão um homem negro, acusado de um roubo em uma loja de luxo.

Além de racistas, softwares de reconhecimento facial também podem ser transfóbicos. Uma pesquisa feita em 2019 na Universidade do Colorado (EUA) mostrou que eles tendem a errar mais com pessoas trans em comparação a pessoas cisgêneros.

O Google também recebeu uma denúncia, em 2015, de que a plataforma havia rotulado a foto de um casal negro com a legenda "gorilas". A empresa afirmou na época que tomaria as medidas necessárias para evitar a repetição de erros como esse.

Com o Flickr aconteceu um problema semelhante. No lugar de gorilas, a plataforma rotulou com a palavra "macacos" em fotos de pessoas negras.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.