Com didatismo, "Coded Bias" é um "O Dilema das Redes" sobre falhas das IAs

Os mesmos algoritmos que facilitam aspectos da nossa vida também podem ter comportamentos racistas, machistas e/ou fortalecer sistemas autoritários de vigilância com o reconhecimento facial. O documentário "Coded Bias" da Netflix reúne provas e mostra de forma didática —assim como "O Dilema das Redes" fez com as redes sociais— exemplos de violação de direitos civis e falhas inaceitáveis que a inteligência artificial (IA) vem cometendo. Dirigido pela cineasta e ativista Shalini Kantayya, o filme estreou no Brasil nesta semana.

A experiência pessoal e profissional de Joy Buolamwini, pesquisadora ganense-americana do MIT (Instituto de Tecnologia de Massachusetts), é o fio condutor de toda a narrativa. Ela ficou conhecida após provar que sistemas de reconhecimento não são precisos ao identificar pessoas negras, principalmente mulheres. Essa falha abre um leque enorme de riscos para pessoas não brancas, como por exemplo o uso de tecnologias como essas pela polícia.

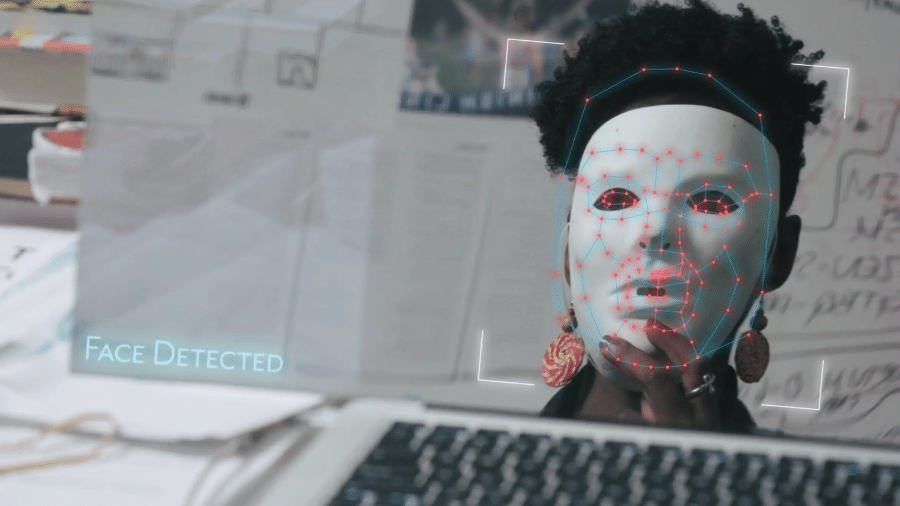

Logo no início do documentário, Buolamwini demonstra o erro de um sistema de análise facial com uma simples ação. Ela posiciona o seu rosto em frente a um espelho com a IA. Quando ela coloca a máscara branca, o sistema detecta a face. Quando tira, nada acontece.

"Os sistemas não conheciam muitos rostos como o meu. Foi aí que comecei a investigar a questão do viés na tecnologia", afirmou Buolamwini. Softwares de empresas como IBM, Microsoft, Google e Amazon foram analisados posteriormente. Os algoritmos foram melhores ao reconhecer rostos de homens brancos.

Outras profissionais importantes dentro do universo da inteligência artificial também deram suas contribuições para a discussão. Alguns destaques são:

- Cathy O'Neil, matemática e autora do livro "Weapons of Math Destruction" (Algoritmos de Destruição em Massa, na versão em português)

- Meredith Broussard, jornalista e autora do livro "Artificial Unintelligence: How Computers Misunderstand the World" (Desinteligência Artificial: como os computadores entendem mal o mundo, na tradução livre)

- Safiya Umoja Noble, professora da Universidade da Califórnia em Los Angeles e autora do livro best-seller "Algorithms of Oppression: How Search Engines Reinforce Racism" (Algoritmos de opressão: como os motores de busca reforçam o racismo, na tradução livre)

- Silkie Carlo, diretora do Big Brother Watch, iniciativa que monitora o uso experimental do reconhecimento facial pela polícia do Reino Unido

Por que o algoritmo é racista

O documentário mostra como tecnologias não são neutras e trabalham com vieses que excluem pessoas. E você nem precisa imaginar um robô superavançado cometendo erros.

Os algoritmos discriminatórios estão entre nós nas coisas mais simples. Faça um teste: abra a sua rede social de fotos e vídeos favorita. Simule uma selfie e veja a quantidade de filtros capazes de transformar o seu rosto, afinar o nariz, reduzir os olhos. Tem muita inteligência artificial nisso que usa erroneamente características de pessoas brancas para determinar o que é bonito e o que é feio.

O exemplo acima envolve os algoritmos visíveis. Agora, imagine os que a gente não tem contato constante? A IA já é usada para determinar se uma pessoa merece receber um crédito no banco ou não, se uma pessoa deve ser presa e se ela merece prioridade no atendimento no hospital, de acordo com o documentário.

Tudo isso passa pela capacidade da tecnologia aprender e agir independentemente de mãos humanas. É o chamado aprendizado de máquina (machine learning, em inglês).

"Ensinamos máquinas fornecendo exemplos do que queremos que elas aprendam. Se quero uma máquina detecte rostos, vou fornecer vários exemplos do que é rosto e do que não é rosto", explicou Buolamwini.

O problema é que os dados usados nesse aprendizado são distorcidos. O volume de informações que alimenta a tecnologia se baseia em falhas de comportamento da sociedade, como o preconceito de raça e de gênero. "Usarmos dados distorcidos para treinar tais sistemas acarreta em resultados distorcidos. O passado está marcado em nossos algoritmos", completou a pesquisadora do MIT.

Meredith Broussard destaca que o conceito de normalidade no universo da tecnologia provém de um grupo de pessoas pequeno e homogêneo. Isso influencia os vieses inconscientes de pessoas, empresas e, consequentemente, sistemas. Por isso, é tão importante que os algoritmos sejam desenvolvidos dentro de um ambiente que valorize a diversidade —já falamos em Tilt o quanto isso é mais do que urgente.

Dados dão poder

Cath O'Neil amplia a discussão reforçando a sua preocupação sobre o poder que empresas e governos têm ao se tornarem donos de enormes volumes de dados pessoais da populacão.

O risco é de que a matemática seja cada vez mais usada como escudo para práticas corruptas. "Os donos do código o empregam sobre outras pessoas. É uma relação totalmente assimétrica [de poder]. As pessoas estão sofrendo danos algorítmicos e não há responsabilização. Por que aceitamos isso?", afirmou O'Neil, em uma palestra sobre mentes e máquinas exibida pelo documentário.

O uso do reconhecimento facial como argumento para aumentar a segurança dos cidadãos é um aspecto importante nessa relação de poder. Vemos cenas de manifestantes em um grande protesto em Hong Kong usando lasers para confundir as câmeras de vigilância e a abordagem de policiais em Londres contra um homem que escondeu o seu rosto por não concordar com um sistema de análise da sua face.

Silkie Carbo, da iniciativa Big Brother Watch, mostrou no "Coded Bias" que 98% das correspondências obtidas por câmeras que alertam a polícia do Reino Unido identificaram incorretamente inocentes como se fossem foragidos.

"Ter a sua foto biométrica num banco de dados da polícia é como ter suas digitais ou seu DNA. E temos leis sobre isso. A polícia não pode sair coletando digitais e DNA. Mas, neste sistema esquisito que temos atualmente, eles podem tirar foto biométrica de qualquer um e mantê-la armazenada", afirmou Carbo.

Mais de 117 milhões de pessoas nos Estados Unidos têm o rosto em redes de reconhecimento facial que a polícia pode acessar, segundo dados do documentário. "É facílimo criar um estado de vigilância em massa com as ferramentas que já existem, afirma Buolamwini.

Outros casos que provam como a tecnologia discrimina:

- Um condomínio de apartamentos no Brooklyn, nos Estados Unidos, adotou o reconhecimento facial para o acesso de moradores sem qualquer regulação. O bairro é majoritariamente composto pelas comunidades negra e latina. Muitos se sentem incomodados com o nível de vigilância, violação de privacidade e riscos de erros na hora de analisar os seus rostos;

- Um professor nos Estados Unidos com vários prêmios recebidos por sua contribuição para a educação foi demitido após um algoritmo ter considerado o seu desempenho ruim;

- Um adolescente negro de 14 anos foi cercado pela polícia em Londres por ter sido apontado como suspeito por uma tecnologia de análise facial. Ele foi liberado por ser inocente;

- A Amazon já usou um sistema de seleção de profissionais automatizado. O programa era tendencioso contra mulheres e escolhia homens para as vagas. A empresa abandonou a plataforma posteriormente;

- A empresa UnitedHealth Group foi investigada após um estudo revelar que um algoritmo priorizava atender pacientes brancos menos graves do que pacientes negros.

"Se não ficarmos de olho, tais algoritmos podem propagar o viés que tanta gente arrisca a vida para combater", ressaltou Buolamwini. Para ela e outros especialistas entrevistados para o documentário, é preciso ter regulações específicas sobre inteligência artificial. Sem elas, não há nenhum tipo de recurso em caso de abusos dessas tecnologias.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.