'Bisorro' e 'preda': como robô esperto saca o que você fala, até os erros

Sem tempo, irmão

- Tilt conversou com a responsável por ensinar português à inteligência artificial do Google

- A linguista Larissa Rinaldi conta como uma máquina consegue ouvir, entender e falar

- Um ano inteiro foi gasto só ensinando o robô a entender os sons de palavras e sentenças

- Conversas entre pessoas e máquinas são mais complexas do que o 'Ok, Google' faz parecer

Basta dizer "Ok, Google" ou "Hey, Alexa" para despertá-los. Atentos, sabem o que fazer meio segundo após um pedido e sempre avisam o que farão, parecendo educados seres humanos. Mas estamos falando de assistentes virtuais. Plataformas de inteligência artificial que ouvem, falam e nos entendem. Como elas conseguem?

Ao Tilt, a profissional do Google responsável por ensinar máquinas a entenderem você em alto e - nem sempre— bom português explicou como estes robôs compreendem diferentes sotaques, falam novas palavras e não julgam ninguém por falar "preda" ou "bisorro", em vez de pedra e besouro.

Em uma área dominada por especialistas em algoritmos, a praia da paulistana Larissa Rinaldi, 34 anos, é outra: dar ao Google Assistente a habilidade de falar uma frase com sujeito, verbo e predicado. Ela largou o doutorado na Unicamp para integrar a equipe que, em 2013, ensinou às ferramentas do Google a falar português. No ano passado, passou a liderar de Londres uma equipe que aperfeiçoa a capacidade de comunicação da plataforma.

A gente não tem muito essa de falar certo ou falar errado. Linguística não é normativa, isso é coisa da gramática. Ela serve para estudar a linguagem viva, que é falada pelas pessoas

Larissa Rinaldi, especialista do Google em linguística

A construção da inteligência

Uma conversa com um robô começa muito antes de você dizer "Ok, Google".

Sistemas como o Google Assistente são plataformas que mesclam algoritmos criados por especialistas e "aprendizado de máquina" (um dos segmentos da Inteligência artificial), ou seja, adquirem conhecimento após serem submetidas a exemplares de determinado conteúdo.

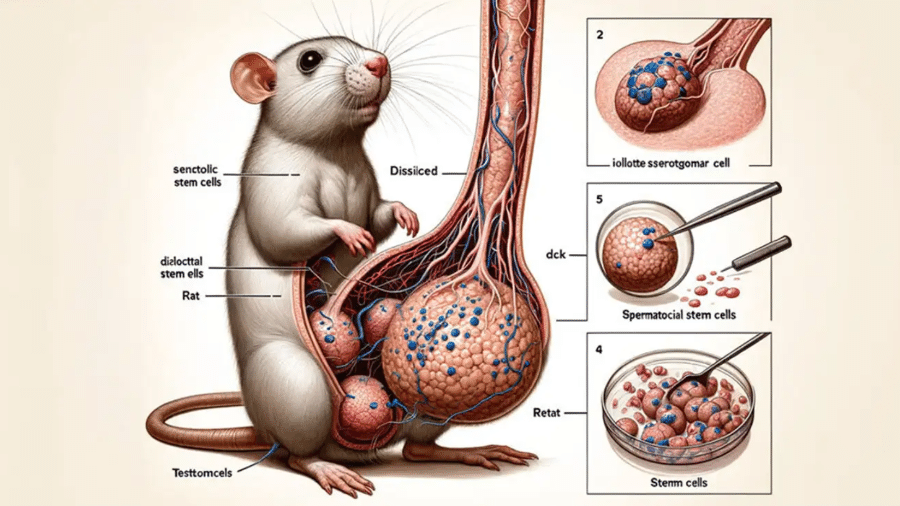

Um sistema de reconhecimento de imagem, por exemplo, é bombardeado com milhões de fotos até que consiga compreender as características mais essenciais de objetos, pessoas, animais ou plantas. O mesmo ocorre com ferramentas que entendem o que as pessoas falam.

Depois de treinado, o sistema consegue analisar dados com base no que aprendeu. Por exemplo: ele pode ser especialista em reconhecer quais animais, plantas e objetos estão retratados em uma fotografia, mas provavelmente não vai diferenciar entre o latido de um cachorro, o miado de um gato ou o choro de um bebê.

Para facilitar o trabalho, há diversos bancos de dados repletos com imagens e áudios. Só que não há uma base dessas para ensinar semântica ou sintaxe a máquinas. Esse foi um dos primeiros desafios de Rinaldi no Google. "A gente teve que fazer tudo na unha", diz. Isso foi no passado, pois atualmente já há bases com esses tipos de dados.

Falando com robôs

1) Ouvir

Assim que você diz "Ok, Google", o aparelho começa a registrar o que está sendo dito. O texto falado é transformado em texto escrito, é gravado e mandado para a nuvem, onde será processado. O sistema começa a adaptar o que foi dito às regras da língua. Mas isso não quer dizer que sentenças incorretas como "as coisa tudo" sejam simplesmente descartadas.

"Se você só falar "bizorro" ou "preda", ele até vai ter dificuldade de entender. Mas, se tiver um contexto, como em 'Poemas sobre 'preda', vai entender", diz. Ela explica que, na hora da transcrição, o sistema não encontrará um correspondente para a palavra ou expressão, mas vai escrever o que mais se aproxime fonética e gramaticalmente e tenha um significado que se encaixe.

Uma coisa aparentemente complicada, mas que a máquina tira de letra, é compreender diferentes sotaques. "Não tem nenhum problema, porque, em lógica, eu posso dizer que 1, 2 e 7 são iguais a X", diz ela. Isso quer dizer que o sistema registra, ainda que de formas diferentes, as várias formas de dizer uma mesma palavra.

2) Entender

Na segunda etapa, o sistema analisa o que a sentença quer dizer do ponto de vista semântico. Ou seja, a relação entre as palavras e o significado que produzem juntas.

"Se eu falar 'quero um voo de São Paulo a Nova York', é preciso entender que 'voo' é a palavra responsável para levá-la a uma ação. Em 'Um voo direto de São Paulo a Nova York na classe econômica', a máquina entende que 'direto' e 'classe econômica' são coisas que estão modificando o termo 'voo' e não todas as outras coisas na sentença, como 'São Paulo'", explica Rinaldi.

3) Falar

Após compreender a mensagem, ou seja, a intenção da pessoa, chega a hora de acionar os serviços que irão dar cabo do pedido. Antes disso, o robô faz outra coisa: por meio de texto ou em voz alta, diz o que está prestes a fazer.

Durante um ano, Larissa integrou um time de linguistas que trabalharam para dar voz ao Google no Brasil —primeiro, gravaram palavras e sentenças, de modo a explorar todas possibilidades fonéticas da língua portuguesa. Depois partiram para a transcrição fonética do material, ou seja, os sons de cada elemento. Isso permitiu que hoje a máquina possa formar novas palavras a partir dos fonemas de termos já registrados.

Um exemplo: se o sistema precisa dizer "banco", uma palavra que já faz parte de seu vocabulário, é como se alguém apertasse play e ele a falasse automaticamente. Para um termo novo, ele busca fonemas similares em outras palavras já registradas. Se precisasse aprender "banco", ele pegaria o "ban" de "banda" e o "co" de "panco", juntaria os dois arquivos e dispararia a combinação.

4) Fazer

Finalmente, chega a hora de responder a perguntas ou executar tarefas. Até agora, o processo é semelhante para todas as empresas que possuem assistentes pessoais, como Apple, dona da Siri, ou Amazon, da Alexa. A partir de agora, porém, as ações a serem feitas pelos robôs dependem da estratégia tecnológica ou das parcerias comerciais de cada empresa.

Se for uma pergunta, o assistente busca a resposta na internet. O Assistente e a Alexa já dão respostas em alto e bom som, tiradas de fontes confiáveis ou do conteúdo de parceiros, enquanto a Siri só exibe o que achou online. Mas os assistentes de Google e Amazon nem sempre têm a resposta na ponta da língua. Quando nada dá certo, mostram resultados achados na web.

Se for uma tarefa, o resultado pode depender:

- dos serviços configurados para a conta do usuário: se o serviço de streaming de música habilitado for o Spotify, pedidos por música abrirão automaticamente nesse app, mas não no YouTube Música, a não ser que isso seja dito explicitamente;

- das aplicações que a própria empresa tenha: pedir à Siri para agendar um compromisso fará com que ela insira a atividade no Calendário, uma aplicação da Apple, ao passo que o Assistente vai preferir o Google Agenda;

- das parcerias de cada companhia: o UOL oferece o "Boletim Ecoa de boas notícias" para o Google Assistente e, para a Alexa, o UOL Horóscopo e as últimas novidades do mundo dos esportes. Para ambos, há boletins de notícia.

Tem alguém me ouvindo aí?

Há alguns meses, surgiu a notícia de que funcionários de uma empresa terceirizada do Google ouviam conversas dos usuários gravadas a partir de seu serviço inteligente.

A especialista do Google explica que o sistema só libera acesso a funcionários das transcrições e somente das expressões que foram ditas mais de 50 vezes — os dados são anonimizados e agregados a outros. Se for algo inteiramente novo, os analistas decidem se é o caso de submeter o Assistente ao áudio para ele aprender.

Para ações que envolvam dados pessoais, como pedidos para realizar ligações telefônicas, são necessárias mais ocorrências para entrar no banco. Ainda assim, são suprimidos das transcrições os trechos em que há informações privadas, que poderiam levar à identificação de alguém.

Segundo o Google, os dados enviados à nuvem para serem processados não ficam mais de 60 dias armazenados.

Sem papo

Rinaldi diz que fazer um robô bater papo é complicado, mas não impossível. Na verdade, o Google já testa nos Estados Unidos o Duplex, uma ferramenta que dá ao Assistente o poder de realizar sozinho conversas em ligações telefônicas para marcar horário no cabeleireiro ou reservar uma mesa no restaurante.

"Quando a gente fala de diálogo e conversação, tem muita referência externa. Se eu falo 'Qual é a altura do Obama?' e depois pergunto 'ele é casado?', é possível fazer análises simples e entender a quem 'ele' se refere. Outros tipos de referência seriam impossíveis de resolver. Algumas até seriam possíveis, mas precisaria acessar mais dados", diz.

Ela dá um exemplo: se alguém que reclama diariamente para o Google que bate o dedinho na quina do sofá peça uma solução para "aquele problema", a empresa teria que monitorar esse usuário 24 horas por dia para se dar conta de que ele está falando da mesma coisa.

Até que a tecnologia avance ao ponto de a gente não precisar quebrar a privacidade do usuário e conseguir acessar todos esses níveis de informação, a gente fica de mão atada

SIGA TILT NAS REDES SOCIAIS

- Twitter: https://twitter.com/tilt_uol

- Instagram: https://www.instagram.com/tilt_uol/

- WhatsApp: https://uol.page.link/V1gDd

- Grupo no Facebook Deu Tilt: http://bit.ly/FacebookTilt

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.