Quer um clone? Ter sua versão digital e eterna é menos viagem do que parece

Sem tempo, irmão

- Avatares que reproduzam consciência de mortos estão em desenvolvimento

- O aumento do processamento, dos dados e a "imortalidade" motivam pesquisas

- Por um lado, podemos nos ficcionalizar assim em vez dos diários e meditação

- Mas a ferramenta, caso seja para substituir pessoa, se tornaria empobrecedora

Mesmo depois de morto, vivo para família e amigos. Uma frase dessas é normalmente uma metáfora ou tentativa de consolo. Mas pode deixar de ser, pelo menos no mundo digital.

O aumento da capacidade de processamento de dados, o volume exponencial de informações sobre todos nós e a busca eterna dos humanos pela imortalidade têm feito com que diversas empresas invistam na criação de avatares que reproduzam a consciência de uma pessoa.

Por enquanto, iniciativas como essa ainda são experimentais. Ainda assim, é difícil ouvir esse papo e não lembrar de "Volto Já", episódio de segunda temporada de "Black Mirror" em que uma mulher compra um simulacro do seu recém-falecido namorado que acaba se transformando em um estorvo.

Gasparzinhos da nova era

Em teoria, esses clones virtuais permitiriam a quem ficou para trás no mundo dos vivos continuar a conversar e conviver com o finado.

Uma das iniciativas do tipo mais famosa se chama Replika, e é encabeçada pela russa Eugenia Kuyda. Quando um amigo chamado Roman Mazurenko morreu, em 2015, ela alimentou um algoritmo de aprendizado de máquina com milhares de emails e mensagens escritas por Roman para criar um chatbot que o emulasse.

O resultado das interações com o Roman virtual variavam. Às vezes a conversa não fazia sentido, e em outras Eugenia via no computador um resquício do amigo. Também não havia por parte do bot sensibilidade em distinguir com quem ele falava e um assunto que se restringiria ao seu círculo íntimo aparecia em interação com estranhos.

De qualquer forma, o experimento serviu como ponto de partida para oferecer o Replika como um app que permite a qualquer um criar chatbots —isto é, réplicas textuais de si mesmo. Algo como um melhor amigo digital moldado ao próprio gosto.

O app já foi baixado mais de dois milhões de vezes e tem pelo menos 200 mil usuários mensais —um grupo brasileiro no Facebook conta com mais de três mil membros.

Os perigos dessa ideia

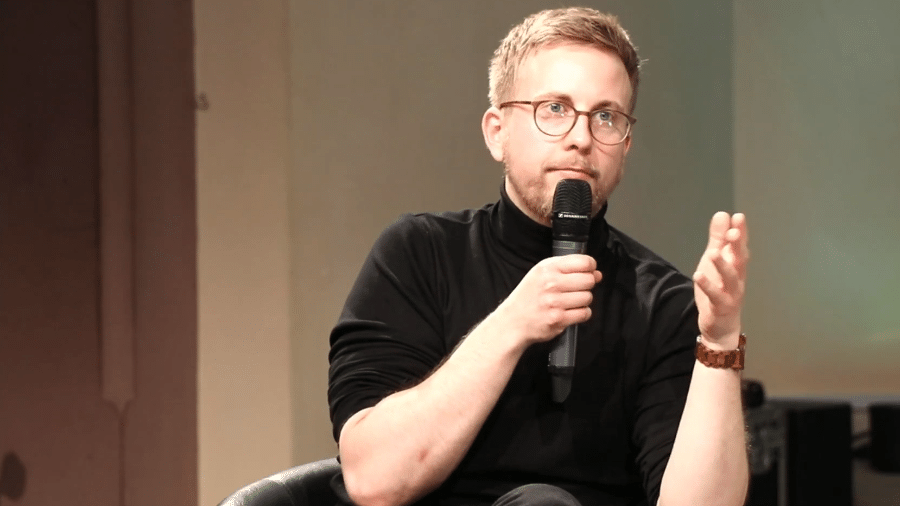

Na opinião do psicanalista e colunista de Tilt Christian Dunker, esta pode ser uma faca de dois gumes. "A simulação pode vir a enriquecer essa maneira de se ficcionalizar de forma mais potente, que cumpriria a função similar a diários, escrita e meditação", afirma.

Por outro lado, caso a ferramenta fosse utilizada na tomada de decisões ou para de alguma forma substituir o criador, ela se tornaria empobrecedora. "O algoritmo estaria sendo usado não para criar novas experiências, mas para se defender delas", diz Dunker.

Aproveitar experiências antigas é o objetivo de outro pesquisador que trabalha na área. Dentro do MIT Media Lab, Hossein Rahnama criou o projeto Augmented Eternity para atender a demanda de um executivo que deseja imortalizar sua expertise na área.

O conhecimento do executivo —nunca identificado— será transferido para um avatar capaz de aconselhar e orientar outros profissionais na tomada de decisões. Assim como Replika, para chegar nesse ponto o software demanda interações constantes com o CEO.

Rahnama acredita que o acúmulo de informações e rastros digitais deixados na internet serão o suficiente para criar um avatar sem a necessidade de suporte da pessoa copiada. "Nós estamos gerando gigabytes de dados diariamente", disse o pesquisador ao MIT Technology Review.

"O [sociólogo espanhol] Manoel Castells defende que não existe mais fronteira entre online e offfline, e eu creio que a próximo fronteira a cair é entre o orgânico e o inorgânico", diz o advogado e pesquisador Eduardo Magrani, autor do livro "Entre Dados e Robôs: Ética e Privacidade na Era da Hiperconectividade". "As novas gerações vão estar tão habituadas a interagir com personas virtuais que vão esquecer que estão interagindo com chatbots", afirma.

Quem quer viver para sempre?

Para Christian Dunker, isso é uma evolução do problema do que fazer com as contas de pessoas mortas em redes sociais". Ainda que um avatar pudesse ser usado de forma saudável como um memorial para aquela pessoa, há um grande potencial de afetar de forma negativa o processo de luto.

"O luto tem três operações principais. O primeiro é realizar o que aconteceu. O segundo é alternar afetos, você se sentido culpado e intercala com sentir raiva da pessoa, como se tivesse sido abandonado aqui. O terceiro é quando começa a entender que ela se foi mesmo, mas deixou coisas para você, memórias, experiências, pode sentir saudades em relação a ela e não só dor", explica. "Essa emulação da pessoa pode interferir no processo substituindo a dor inicial."

E essa é só uma das questões. No ano passado, Carl Öhman e Luciano Floridi, ambos do Oxford Internet Institute da Universidade de Oxford, publicaram um artigo chamado An Ethical Framework in the Digital Afterlife Industry (algo como 'Um padrão ético para a indústria do pós-vida digital').

No texto, os dois ressaltam que por trás de pesquisas do tipo há um interesse no lucro e não há nenhum tipo de regra que determine como empresas podem ou não lidar com bots e dados utilizados para criá-los.

Para complicar ainda mais, vale sempre lembrar que ainda estamos longe de desenvolver algoritmos de inteligência artificial que sequer se aproximem da complexidade do cérebro humano. Além disso, a depender da tecnologia utilizada, o bot criado a partir de uma pessoa continuaria a se moldar e aprender conforme as interações com o mundo.

E aí pode ficar feio assistir o vovô digital que viverá para sempre deixar de lado a personalidade carinhosa e acolhedora e se transformar em um racista misógino cheio de ódio.

Por conta disso, é fundamental que as empresas que disponibilizam ferramentas como essas deem informações claras aos usuários sobre quais dados são utilizados e, caso empreguem aprendizado de máquina, quais das expressões ditas pelos avatares foram criadas pela pessoa emulada em vida, e quais foram criadas pelo algoritmo de inteligência artificial.

A avaliação é de Eduardo Magrani, que sugere um cenário desafiador: "Se uma frase dita por esse chatbot causar dano, for racista, por exemplo, uma pessoa externa vai auditar o sistema para ver de onde vem o dano e quem pode ser responsabilizado. Se vem do aprendizado de máquina, pode-se responsabilizar a empresa ou eventualmente o próprio robô", explica.

Pelo visto, o processo de criarmos nossos próprios clones virtuais desde já não está nada fácil.

SIGA TILT NAS REDES SOCIAIS

- Twitter: https://twitter.com/tilt_uol

- Instagram: https://www.instagram.com/tilt_uol/

- WhatsApp: https://uol.page.link/V1gDd

- Grupo no Facebook Deu Tilt: http://bit.ly/FacebookTilt

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.