Como funciona o LaMDA, cérebro artificial do Google 'acusado' por engenheiro de ter consciência própria

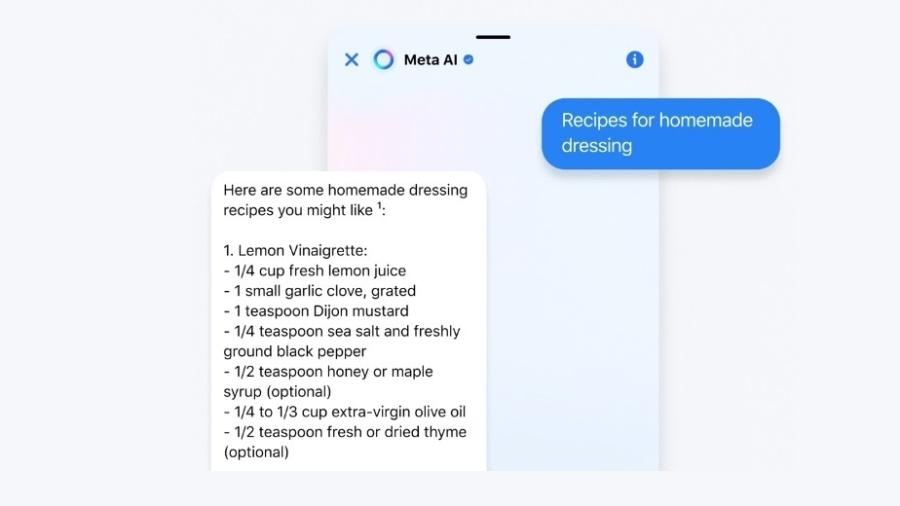

LaMBDA é um cérebro artificial, hospedado na nuvem, com trilhões de textos armazenados e que treina sozinho.

Uma máquina pensante e consciente. Foi assim que o engenheiro do Google Blake Lemoine definiu o LaMDA — o sistema de inteligência artificial do Google.

Lemoine foi afastado de suas funções pela empresa.

"Nossa equipe —que inclui especialistas em ética e tecnologia — revisou as preocupações de Blake de acordo com nossos Princípios de IA e o informou de que as evidências não respaldam suas alegações", afirmou Brian Gabriel, porta-voz do Google, em comunicado.

Mas como funciona essa máquina?

Se nos lembrarmos dos antigos filmes de ficção científica, poderemos imaginar LaMDA como um robô que assume a forma humana, abre os olhos, ganha consciência e fala. Ou como HAL-9000, o supercomputador do filme 2001: Uma Odisseia no Espaço ? que, em uma paródia de Os Simpsons, ganha a voz de Pierce Brosnan no original em inglês, apaixona-se por Marge e quer matar Homer.

Mas a realidade é um pouco mais complexa. O LaMDA é um cérebro artificial e está abrigado na nuvem. Sua alimentação é composta por milhões de textos e ele próprio faz seu treinamento. Mas, por outro lado, age como um papagaio.

Muito complicado? Vamos por partes, para entender melhor.

Supercérebro

O LaMDA (sigla em inglês para Modelo de Linguagem para Aplicativos de Diálogo) foi projetado pelo Google em 2017. Sua base é um transformer, ou seja, um emaranhado de redes neuronais artificiais profundas.

"Essa rede neuronal treina a si própria com grandes quantidades de texto. Mas o aprendizado tem um objetivo, que é apresentado na forma de um jogo. Ela tem uma frase completa, mas falta uma palavra, e o sistema precisa adivinhá-la", explica Julio Gonzalo Arroyo, professor da Uned (Universidade Nacional de Educação à Distância), na Espanha, e principal pesquisador do departamento de processamento de linguagem natural e recuperação de informações.

O sistema joga consigo mesmo. Ele coloca palavras por tentativa e erro e, quando erra, age como se fosse um caderno de atividades infantis ? olha as últimas páginas, vê a resposta correta e assim vai corrigindo e refinando os parâmetros.

E ele também "identifica o significado de cada palavra e observa as outras palavras em torno dela", segundo Gonzalo Arroyo. Assim, ele se torna especialista em prever padrões e palavras. É um processo similar à previsão de texto dos telefones celulares, mas elevado à enésima potência, com uma memória muito maior.

Respostas de qualidade, específicas e com interesse

Mas o LaMDA também cria respostas fluidas e espontâneas ? e, segundo o Google, com capacidade de recriar o dinamismo e reconhecer as nuances da conversa humana. Em resumo: que não pareçam ter sido criadas por um robô.

Essa fluidez é um dos objetivos do Google, segundo indica seu blog de tecnologia. E eles afirmam que conseguem atingir esse objetivo, assegurando que as respostas sejam de qualidade, específicas e que demonstrem interesse.

Para que tenham qualidade, as respostas precisam fazer sentido. Se eu disser ao LaMDA, por exemplo, "comecei a tocar guitarra", ele deve responder algo relacionado à minha informação, não qualquer coisa sem sentido.

Para que o segundo objetivo seja cumprido (a resposta específica), o LaMDA não deveria responder com "muito bem", mas sim algo mais específico, como: "qual marca de guitarra você prefere, Gibson ou Fender?"

E, para que o sistema forneça respostas que demonstrem interesse e perspicácia, ele deve atingir um nível mais elevado. Por exemplo: "a Fender Stratocaster é uma boa guitarra, mas a Red Special de Brian May é única".

O segredo para responder com esse nível de detalhamento é o autotreinamento. "Depois de ler bilhões de palavras, [o sistema] tem uma capacidade extraordinária de intuir quais são as palavras mais adequadas em cada contexto."

Para os especialistas em inteligência artificial, transformers como o LaMDA representam um desafio porque "permitem processamento [de informações ou textos] muito eficiente e produziram uma autêntica revolução no campo do processamento da linguagem natural".

Segurança e tendência

Outro objetivo do treinamento do LaMDA é não criar "conteúdo violento ou desumano, não promover calúnias nem discursos de ódio contra grupos de pessoas e não conter blasfêmias", segundo o blog de inteligência artificial (IA) do Google.

Também se deseja que as respostas sejam baseadas em fatos e que haja fontes externas conhecidas.

"Com o LaMDA, estamos adotando um enfoque cuidadoso e ponderado para levar mais em conta preocupações válidas sobre imparcialidade e veracidade", afirma Brian Gabriel, porta-voz do Google.

Ele defende que o sistema já passou por 11 revisões diferentes dos Princípios da IA, "além de uma pesquisa rigorosa e testes baseados em medidas fundamentais de qualidade, segurança e da capacidade do sistema de produzir declarações baseadas em fatos".

Mas como fazer com que um sistema como o LaMDA não seja tendencioso, nem apresente mensagens de ódio? "O segredo é selecionar quais dados [quais fontes de texto] devem ser alimentados no sistema", afirma Gonzalo Arroyo.

Mas isso não é fácil. "A nossa forma de comunicação reflete nossas tendências e as máquinas aprendem isso. É difícil eliminá-las dos dados de treinamento sem perder a representatividade", explica ele.

Ou seja, é possível que surjam tendências.

"Se você alimenta notícias sobre a rainha Letícia [da Espanha], todas comentando quais roupas ela usa, é possível que, quando alguém pergunte sobre ela ao sistema, ele repita esse padrão machista e fale das roupas e não de outras coisas", destaca o professor.

Papagaio cantor

Em 1966, foi projetado um sistema chamado ELIZA que aplicava padrões muito simples para simular o diálogo de uma psicoterapeuta.

"O sistema incentivava o paciente a contar mais, seja qual fosse o tema da conversa, e acionava padrões como 'se mencionar a palavra família, pergunte como é a relação com sua mãe'", conta Gonzalo.

Algumas pessoas chegaram a pensar que ELIZA realmente era uma terapeuta ? até afirmavam que os havia ajudado. "Nós, seres humanos, somos enganados com relativa facilidade", afirma Gonzalo Arroyo.

Para ele, a afirmação de Lemoine de que o LaMDA ganhou consciência de si mesmo "é um exagero". Segundo o professor, declarações como a de Lemoine não ajudam a manter um debate saudável sobre a inteligência artificial.

"Ouvir esse tipo de bobagem não é benéfico. Corremos o risco de que vire mania e as pessoas pensem que estamos em modo Matrix, com as máquinas prontas para acabar conosco. Isso é algo remoto, é utópico. Não acredito que ajude a ter uma conversa ponderada sobre os benefícios da inteligência artificial", segundo Gonzalo Arroyo.

Por mais que a conversa seja fluida, de qualidade e específica, "não passa de uma gigantesca fórmula que ajusta os parâmetros para prever melhor a palavra seguinte. Ele não tem a menor ideia do que está falando."

A resposta do Google é similar. "Esses sistemas imitam os tipos de intercâmbio encontrados em milhões de frases e podem falar sobre qualquer tema fantástico. Se perguntarmos como é ser um dinossauro congelado, eles podem gerar textos sobre o derretimento, o rugido etc.", explica Gabriel, do Google.

As pesquisadoras norte-americanas Emily Bender e Timnit Gebru compararam esses sistemas de criação de linguagem com "papagaios aleatórios", que repetem palavras ao acaso.

Por isso, como disseram os pesquisadores espanhóis Ariel Guersenvaig e Ramón Sangüesa, transformers como o LaMDA entendem tanto o que escrevem quanto um papagaio cantando.

- Este texto foi originalmente publicado em https://www.bbc.com/portuguese/geral-61845144

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.